Photo by Morgan Housel on Unsplash

«Io spero che siate almeno in parte convinti che non è impossibile simulare un cervello umano. E possiamo farlo, in dieci anni». Era il 2009 e Henry Markram chiudeva così il suo intervento al TEDglobal di Oxford.

Quattro anni dopo, nel 2013, l’Unione Europea lanciava The Human Brain Project, il rivoluzionario progetto da 1,3 miliardi di euro, fondato e diretto da Markram, che prometteva di creare una simulazione completa degli 86 miliardi di neuroni e 100 trilioni di sinapsi che compongono il cervello umano. Nasceva così il progetto che prometteva quel passo in avanti necessario per capire finalmente come funziona il cervello. In quello stesso periodo, dal 2013 al 2016, i governi di molti altri stati hanno finanziato grandi iniziative mirate allo stesso scopo: gli Stati Uniti il BRAIN Initiative, che questo ottobre ha pubblicato i primi risultati nell’ambito del “censimento” delle popolazioni neuronali; il Giappone il Brain/MIND project, quindi la Cina, l’Australia, la Corea e il Canada. Nasce così l’epoca d’oro della Big Neuroscience, con tanti soldi e obiettivi ambiziosi che inevitabilmente tendono a prosciugare le risorse a discapito della “piccola scienza” dei molti laboratori attivi in questo campo.

Quasi dieci anni dopo, tra progetti che continuano e altri che si avviano alla fine, iniziamo a raccogliere i risultati di quelle ardite scommesse, tra i successi e i fallimenti che in alcuni casi hanno deluso la promessa iniziale (niente simulazione del cervello umano per noi europei) e ci lasciano con una domanda essenziale: ne sarà valsa la pena? Nella sfida fra Davide e Golia, chi vince? Più nello specifico, per capire il cervello meglio la grande o la piccola scienza?

L’epoca della scienza “Moonshot”

Nome in codice: progetto Manhattan. Dal 1942 al 1946 quasi 130.000 persone lavorano al primo vero esempio di grande scienza, che porta allo sviluppo della bomba atomica. Da quel momento, il mondo scopre un nuovo modo di fare ricerca, ovvero progetti finanziati da enti governativi con miliardi di dollari che coinvolgono migliaia di ricercatori provenienti da diverse discipline: la Big Science. La tendenza al gigantismo sembra essere connaturata all’impresa scientifica: più la conoscenza progredisce, più le domande si complicano e le esigenze di risorse, strumenti e personale crescono. Più servono collaborazione e condivisione per dar vita a un approccio multidisciplinare, in cui le diverse prospettive creano un ambiente di interazione dove l’unione eccede la somma delle singole parti.

Nel 1954 nasce il CERN, con il più grande acceleratore di particelle del mondo, con 12 paesi membri fondatori per restituire all’Europa il primato della fisica, oramai nelle mani degli Stati Uniti. Perché la grande scienza ha anche una connotazione politica. I grandi progetti infatti catturano l’attenzione del pubblico, che in cambio del suo supporto vuole una visione entusiasmante e obiettivi straordinari. È l’interesse, in larga parte, a mantenere vivi i finanziamenti, così «lo spettacolare più che la perspicacia diventa lo standard scientifico», come diceva Alvin M. Weinberg, direttore del Oak Ridge National Laboratory, quando nel 1961 coniò il termine “Big Science”. Diventa essenziale per la scienza, come per tante altre attività umane, ottenere l’approvazione pubblica e politica per accedere a più fondi. E un modo è quello di lanciare progetti e “missioni” che facciano sognare la conquista di nuove frontiere: la Luna con la missione Apollo, il disvelamento dell'Universo con Hubble; la lotta senza quartiere al cancro lanciato dal presidente Nixon nel 1971 e rilanciata quest’anno con la mission Cancer di Horizon Europe, il programma quadro della Commissione europea per la ricerca e l’innovazione, o la mappatura completa del genoma umano che nel 1990, con lo Human Genome Project, che raccoglie 3 miliardi di finanziamenti. E cosa se non il disvelamento dei segreti del cervello umano, poteva rappresentare il nuovo Moonshot? Come è oggi l’eroica e diuturna lotta contro il cambiamento climatico. Ma nonostante i successi che i grandi finanziamenti della Big Science hanno raggiunto e che probabilmente raggiungeranno, altrettante sono le potenziali insidie di questo approccio, legate principalmente a un tema chiave: la prospettiva.

Quando l’ambizione è nemica della concretezza: il caso dello Human Brain Project

Le esperienze, più o meno recenti, hanno mostrato che il successo di un progetto di Big Science è correlato alla chiarezza dei suoi obiettivi, che devono essere ben definiti e raggiungibili. Caso eclatante è stato appunto lo Human Brain Project (HBP) che ha suscitato polemiche e controversie fin da subito. Nel 2009, quando per la prima volta condivise la sua visione scientifica, Henry Markram, professore alla scuola politecnica federale di Losanna, era un neuroscienziato affermato, conosciuto principalmente per i suoi studi sulla plasticità sinaptica. Finanziato dal governo svizzero, nel 2005 aveva fondato il Blue Brain project con l’obiettivo di simulare, su un supercomputer IBM Blue gene, il funzionamento di una piccola porzione del cervello di ratto, in particolare concentrandosi sull’unità funzionale (colonna) della corteccia. Il progetto rappresentava per Markram la prova di concetto per la fattibilità del passo successivo: un modello computazionale del cervello umano. Secondo Markram il problema che impediva alla ricerca di svelare i misteri delle neuroscienze era la sua stessa natura: competitiva e disgregata. «Abbiamo prodotto 5 milioni di studi direttamente collegati al cervello. […] Il vero problema è che tutto questo sapere è frammentato, la maggior parte di noi neanche si capisce l’uno con l’altro. E la soluzione è ovvia: dobbiamo mettere insieme i dati, e per farlo abbiamo bisogno di altre discipline». In questo modo, al TEDxCHUV nel 2012, Markram presentava il razionale del nascente Human Brain project, che di lì a poco avrebbe conquistato il supporto dell’Unione Europea. Tuttavia ad appena un anno dal lancio, più di 800 scienziati hanno firmato una lettera critica nei confronti dell’iniziativa , tacciandola non solo di malagestione, autocratica e intrisa di conflitti di interesse, ma soprattutto di mancata credibilità scientifica: per quanto una visione di insieme fosse effettivamente necessaria, il progetto di simulare matematicamente il cervello umano era secondo loro prematuro e irrealizzabile e stava per giunta privando le neuroscienze europee di fondi vitali. I firmatari minacciavano di boicottare il progetto se questo non fosse stato revisionato e riorganizzato.

A seguito di queste critiche, Markram stesso richiese un intervento di mediazione, tramite l’istituzione di una commissione di esperti neuroscienziati, riconosciuti a livello internazionale, interni ed esterni al progetto, che nel marzo 2015 pubblicò un report sull’HBP, confermando i punti critici emersi nella lettera. Questi risultati portarono l’Unione Europea a nominare un proprio comitato di valutazione che riformò in parte il progetto, riorganizzandone la gerarchia manageriale e indirizzandolo verso un approccio più applicativo, come lo sviluppo di risorse tecnologiche di raccolta e analisi dati. A dicembre 2020, HBP lancia la piattaforma EBRAINS, un ambiente virtuale collaborativo per conservare, condividere e integrare dati, con strumenti computazionali e modelli, spaziando dal comportamento alla neurorobotica, comprensivo di un atlante cerebrale. Il tutto si traduce quindi in una piattaforma per lo scambio e l’implementazione di informazioni, sicuramente necessario alla comunità scientifica europea, ma ben diverso dalla riproduzione virtuale del cervello umano in un supercomputer promesso nel 2013.

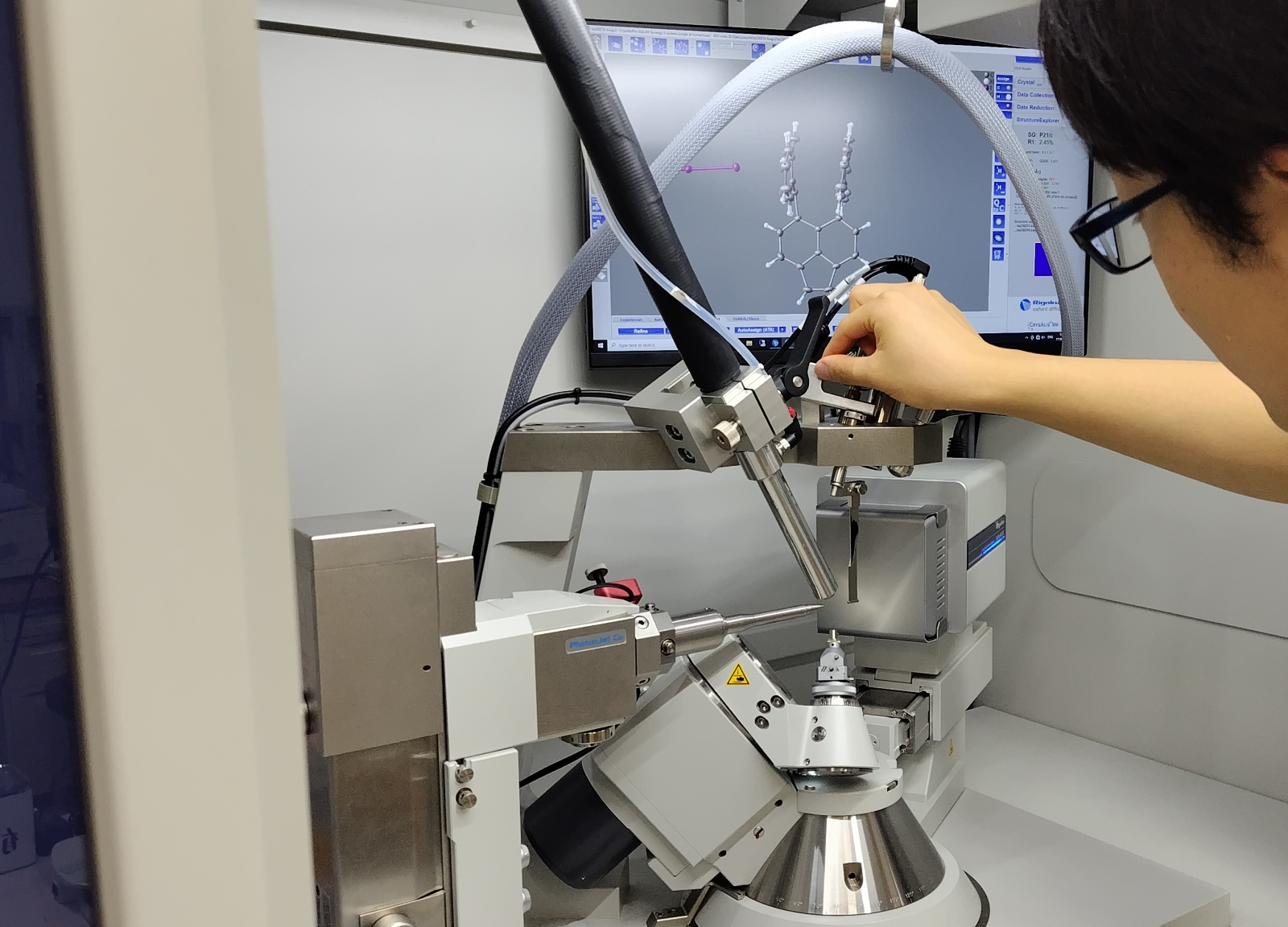

A differenza dello Human Brain Project, la BRAIN Initiative statunitense, fin da subito ha mirato a un più definito ambito tecnologico. Presentato da Barack Obama nel 2013, con 5 miliardi di finanziamenti iniziali per 12 anni, il progetto americano dichiarava l’obiettivo di sviluppare e applicare nuove tecnologie alla comprensione del cervello, e nell’ottobre di quest’anno, un suo sottoprogetto, il Brain Initiative Cell Census Network, ha pubblicato una serie di 17 articoli sulla rivista Nature, proponendo metodi e risultati per una delle prime mappature complete dei neuroni di una porzione della corteccia motoria di topo, con dati preliminari per i primati, umani compresi. I risultati, per quanto non appaiano come un traguardo dirompente, rappresentano uno strumento potenzialmente molto utile per le neuroscienze. Come per la chimica la tavola periodica, un atlante dettagliato e completo di tutti i tipi neuronali potrebbe infatti rivelarsi fondamentale per orientare la ricerca neuroscientifica. E non è un caso che questo sia anche uno degli obiettivi del grande progetto (privato) dell’Allen Institute for Brain Science.

Obiettivi chiari e definiti, sono il punto di partenza per una fruttuosa Big Science che altrimenti mancherebbe di una prospettiva credibile. Ed è proprio con questi presupposti però che la grande scienza mostra un altro suo limite: il basso impatto innovativo.

Carica innovativa vs forza conservativa

Inaspettato forse, ma intuitivo poi, è il concetto che la grande scienza promuove l’avanzamento tecnologico ma non necessariamente un’autentica innovazione, che invece può scaturire dalla “piccola scienza”. Le caratteristiche della Small Science la rendono terreno fertile per le più rivoluzionarie scoperte scientifiche, da cui infatti principalmente provengono. Einstein e la sua teoria, Watson, Crick e il loro DNA, Mullis e la sua PCR (Polymerase Chain Reaction), nessuno di questi cambi di passo vengono da grandi consorzi con obiettivi mirati. Senza considerare il genio del singolo (o della coppia) che è l’emblema più estremo ma raro della piccola scienza, la flessibilità che deriva da budget minori permette ai ricercatori di lasciarsi guidare dalle ipotesi e dalle osservazioni, cambiando rotta se utile, invertendola completamente se necessario. La Small Science autorizza a rischiare, a sbagliare e, a volte, innovare. È la tesi di Lingfei Wu, Dashun Wang e James A. Evans, che in un paper del 2017, parlano proprio della “carica dirompente (disruptive)” insita nelle piccole realtà scientifiche: quella creatività, spesso guidata da curiosità individuale, che spinge oltre o contro i paradigmi convenzionali, fornendo risultati dal reale impatto scientifico. Tale flessibilità non è di certo propria della Big Science che invece si trova a suo agio nel campo del consolidamento. Indirizzata dai dati più che dalle ipotesi, la grande scienza è adatta a testare e applicare su larga scala le innovazioni della piccola (come ha fatto il progetto Manhattan con la teoria della relatività di Einstein) per produrre dati e strumenti, altrimenti irraggiungibili, che a loro volta aprano nuove possibilità e idee sperimentali.

Un rapido sguardo infine va dato alle conseguenze pratiche per la comunità scientifica. Se è vero che la Big Science stimola quel senso di collettività che è proprio della collaborazione scientifica, allo stesso tempo non si addice alla crescita del singolo. Un tale ambiente infatti, spiega Mu-ming Poo, professore emerito dell’UC di Berkley e fondatore dell’istituto per le neuroscienze dell’Accademia cinese, può ostacolare quel rapporto mentore-apprendista di cui hanno bisogno i giovani ricercatori all’inizio del loro percorso, per imparare non solo le tecniche, ma la visione esperta che un capogruppo può trasmettere. Né, allo stesso tempo, si addice alla carriera dello scienziato, ad oggi misurata principalmente con le pubblicazioni in primo nome.

Ripartire dal basso per una nuova sintesi

Con punti di forza e debolezze, le due scienze si parlano, anche se continuano a competere per aggiudicarsi le risorse economiche a disposizione. Se da una parte la grande scienza non può prendere il posto, e tutti i finanziamenti, della piccola, perché diversità e duttilità hanno una loro ragion d’essere, dall’altra è vero che i laboratori minori - nel loro essere frammentati e in competizione - difettano spesso di una visione d’insieme. Piccola e grande scienza non possono fare a meno l’una dell’altra, ma forse il loro rapporto va ripensato.

Questo ottobre, ospitato dal Parlamento europeo, si è tenuto un incontro virtuale della International Brain Initiative, che, fondata nel 2017, raccoglie sotto un unico ombrello tutti i maggiori progetti nazionali di Big Neuroscience (compreso lo Human Brain Project), per promuovere una collaborazione globale sempre meno ridondate e più efficace; un’iniziativa per una scienza “gigante”, che del suo punto di forza ne fa l’obiettivo: la condivisione.

Sempre con questo intento, un’altra opzione è di cambiare direzione alla ricerca di una scienza “media”. Piuttosto che imporre dall’alto un obiettivo comune e troppo vasto, la proposta di Zachary F. Mainen, direttore del Champalimaud Neuroscience Programme, è quella costruire una rete di collaborazioni tra laboratori che già si occupano di temi simili tra loro, in modo da standardizzare il lavoro e unire i frammenti, per una visione di insieme che parta dal basso, ben focalizzata su obiettivi concreti. Sembra infatti più produttivo partire dalle linee di ricerca sulle singole funzioni cerebrali per comporre passo dopo passo una visione generale del cervello, facendo peraltro lavorare insieme neuroscienziati “teorici” e “sperimentali”, mettendo a fattor comune le evidenze emergenti dalle diverse ricerche. Questo livello di scienza collaborativa, fondata su trasparenza e fiducia reciproca, se economicamente incentivata potrebbe rivelarsi un efficace acceleratore nelle neuroscienze.

L’accordo su una nuova strategia ancora non c’è, ma una cosa forse possiamo dirla, in prestito da Orazio: “Est modus in rebus”. C’è una misura nelle cose. Soprattutto quando si parla di cervello.