La diffusione della rete in fibra ottica in Italia supera

di poco l'1%. Tuttavia, secondo le intenzioni del governo, questo digital divide “infrastrutturale”

dovrebbe essere colmato nel giro di pochi anni. In effetti, nel documento La

strategia italiana per la banda ultralarga, presentato a inizio marzo 2015,

l'obiettivo principale è quello di sviluppare una nuova rete sull'intero

territorio nazionale, garantendo al 50% della popolazione un collegamento ad

almeno 100 megabit per secondo (Mbps) entro il 2020.

Il resto dei cittadini potrà invece contare su circa 30 Mbps. Al momento, solo

il 21% della popolazione può trasmettere dati a questa velocità, rispetto alla

media dei paesi europei che ha già raggiunto il 64%.

L'Italia parte quindi da

una situazione di svantaggio, con un ritardo stimabile in circa 3 anni.

Da un punto di vista organizzativo, il territorio

italiano verrà suddiviso in 4 tipologie di cluster

con costi e complessità delle infrastrutture crescenti. La quota di 100 Mbps

verrà garantita nei cluster A e B

(probabilmente solo in parte) mentre quelli C e D arriveranno con ogni

probabilità a 30 Mbps. Il cluster A

include le principali città e aree industriali del Paese, coprendo il 15% della

popolazione (9.4 milioni di persone). Sono previsti misure di defiscalizzazione

degli investimenti. Il Cluster B comprende 1120 comuni, dove risiede il 45%

della popolazione (28.2 milioni di cittadini). Gli operatori forniranno

collegamenti ad almeno 30 Mbps mentre per l'upgrade delle reti sino a 100 Mbps

sarà reso possibile dall’appetibilità di mercato di molte delle zone incluse

oppure da contributi a fondo perduto (in minima parte). Il Cluster C comprende

aree marginali o rurali, per le quali si prevede che gli operatori possano

maturare l'interesse a investire grazie a un sostegno statale. Include circa

2650 comuni per un totale di 15.7 milioni di persone (il 25% della

popolazione). Il Cluster D riguarda alcune aree per le quali solo l'intervento

pubblico potrà garantire alla popolazione residente un servizio di connettività

a più di 30 Mbps. Riguarda, cioè, i restanti 4300 comuni, collocati soprattutto

al Sud. Vi risiedono circa 9.4 milioni di persone (il 15% della popolazione) e

l'incentivo pubblico verrà spesso concesso a fondo perduto.

Un'infrastruttura permette il trasporto delle

informazioni e può rimanere in servizio per molto tempo, anche per oltre 50

anni. La tecnologia, invece, tende a cambiare più velocemente. Nel documento

del governo ne vengono menzionate diverse, alcune ancora in fase di sviluppo.

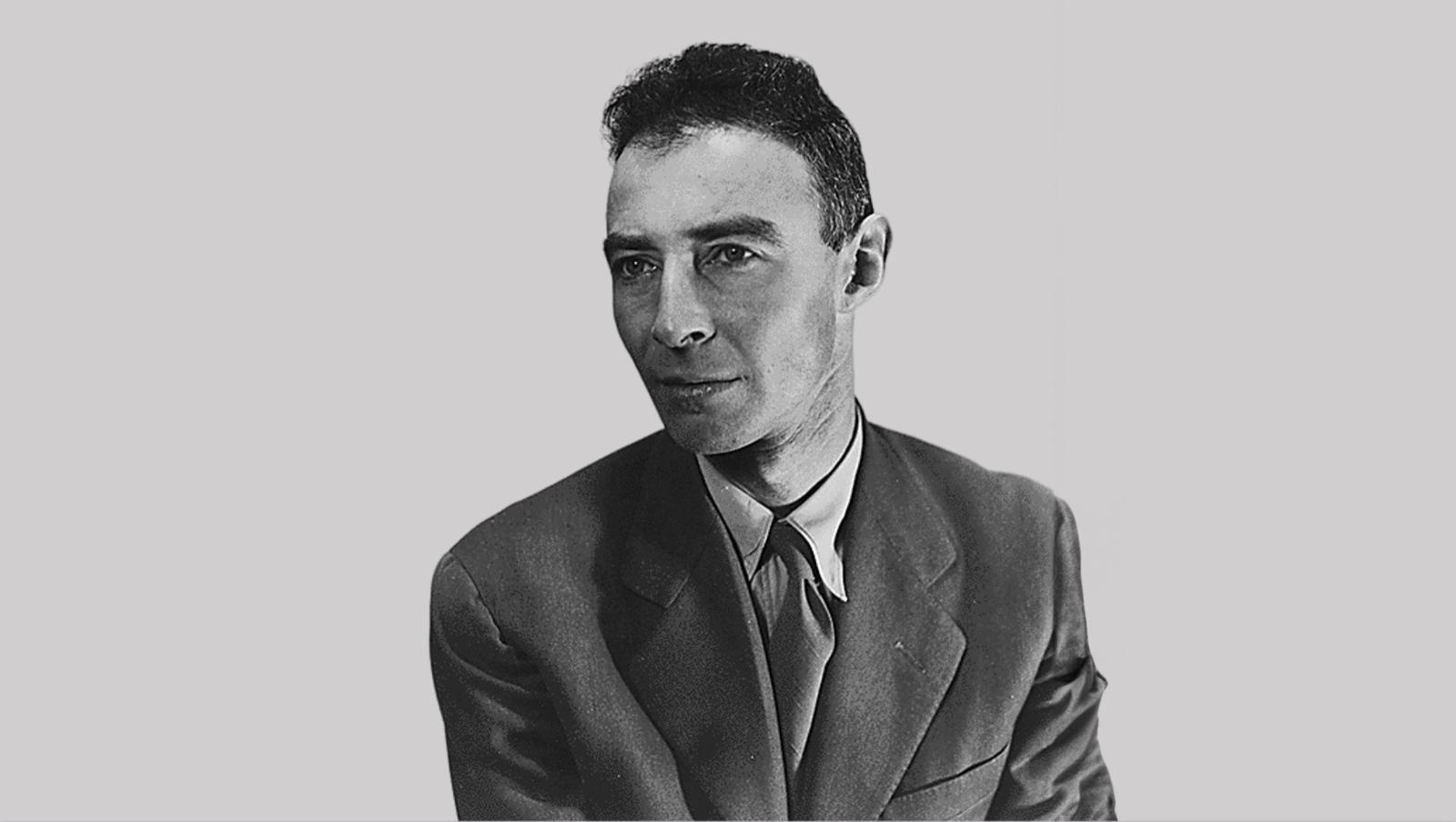

Per capire meglio di cosa si tratta, abbiamo deciso di parlarne con Massimo Carboni, coordinatore del Dipartimento Infrastrutture del GARR, la rete telematica italiana dell'Istruzione e della Ricerca, diffusa capillarmente su tutto il territorio nazionale, che si basa sulle più avanzate tecnologie ottiche di trasporto. In particolare, la rete GARR è già una rete a banda ultralarga, con un altissimo livello di prestazioni e servizi innovativi. Operativa da oltre vent'anni, ad oggi può vantare 9000 km di fibra ottica di dorsale insieme ad altri 4000 km di accesso. La capacità della dorsale arriva a 100 Gbps, mentre la capacità minima dei collegamenti di accesso è di 100Mbps simmetrici, ma possono arrivare fino a multipli di 10Gbps.

Pensando alle tecnologie abilitanti, se vogliamo

raggiungere tutte le famiglie quanto potranno essere importanti i servizi

radiomobili, specialmente nei territori a bassa densità abitativa (aree

rurali)? Per le zone urbane possono invece rappresentare una soluzione a

complemento della rete fissa, comunque necessaria?

La rete mobile è da intendersi a completamento di quella

fissa nelle zone urbane. Per quanto riguarda la modalità di interconnessione

per le aree a bassa densità, qualunque soluzione radio si adotti è comunque

necessaria la fibra ottica per accedere ai servizi internet o telefonici. Il

punto nodale è che nel mobile non c'è garanzia di banda. Se molta utenza fosse

connessa attraverso un servizio di questo genere, avremmo bisogno di un maggior

numero di antenne a loro volte connesse a un sistema in fibra, che risulta

quindi indispensabile. Al momento, la tecnologia radiomobile Long Term

Evolution (LTE) non garantirebbe il raggiungimento degli obiettivi per il 2020.

C'è bisogno di un ulteriore step, con una nuova soluzione tecnica.

In effetti, secondo il documento, la

tecnologia radiomobile LTE non traguarda l'erogazione di almeno 30 Mbps per

utente. Tuttavia, sembra molto promettente quella LTE-Advanced (LTE-A),

attualmente in via di sviluppo e standardizzazione. Potrebbe essere utile anche

per collegare alla rete GARR le scuole più periferiche?

Ragionando in termini capacitivi, LTE consente già oggi

di superare i 30 Mbps. Tuttavia, il punto nodale è che non abbiamo la garanzia

di banda. Questo perché si tratta di modelli a consumo, quindi differenti

rispetto a quelli flat della rete fissa. Per quanto riguarda GARR,

difficilmente adotteremo questa soluzione per le scuole, ma esistono altre

soluzioni radio (Microwave), che arrivano fino a 1 Gbps, che permettono di fare

connessioni punto-punto a distanza dell'ordine di una decina di km, purché non

vi siano ostacoli nel mezzo. Questi sistemi possono essere molto utili in caso

di località montane o per le scuole più periferiche, anche se comunque

richiedono manutenzione frequente, in quanto installazioni all’aperto e

soggetti a fenomeni atmosferici. Quando c'è un guasto, la possibilità di

soluzione può risultare estremamente onerosa.

Secondo il documento, se vogliamo

raggiungere i 100 Mbps, le tecnologie cablate e la realizzazione di impianti in

fibra sembrano essere la soluzione migliore. Quali sono le differenze tra gli

impianti in cui la fibra viene dispiegata fino alla base dell'edificio (FTTB)

oppure alla borchia della singola unità abitativa (FTTH)? Come varia, in

particolare, la capacità trasmissiva a disposizione della singola utenza?

La differenza principale sta nel mezzo trasmissivo. Nel

primo caso, si trasporta l'informazione sino al cabinet, cioè l'armadio

stradale. Da lì il segnale viene trasportato sino a 100-200 metri di distanza

con il doppino di rame. Con questo si raggiungono già, nel 95% delle utenze,

100 Mbps in download e 30 Mbps in upload. La fibra che arriva fino

all’abitazione è invece in grado di trasportare almeno 300-400 Mbps in download

per ogni utente e circa 100 Mbps in upload. La capacità disponibile per singolo

utente dipende comunque dal numero di altre abitazioni connesse e che impegnano

la stessa infrastruttura di accesso.

Attualmente, tra le utenze residenziali non c'è un'alta

domanda di capacità così come nel caso della ricerca. In sostanza,

l'investimento necessario è principalmente quello di portare la fibra nei

piccoli centri mentre per gli ultimi 100-200 metri possono essere sufficienti

soluzioni dai costi più contenuti.

La rete GARR ha delle regole di

utilizzo tali che non prevedono l'uso da parte dei cittadini, in modo da

concentrarsi esclusivamente su ricerca e istruzione. Può valere invece un

discorso inverso? La nuova banda ultralarga a disposizione della popolazione

potrà in qualche modo essere sfruttata dal Consortium per progetti di calcolo

distribuito volontario?

I modelli di tipo social, in cui i singoli cittadini

mettono a disposizione risorse di elaborazione e capacità di calcolo

computazionale, hanno un impatto basso sulla rete. La rete GARR muove circa 15

petabyte di dati al mese, un valore tra l'altro in crescita. Le esigenze degli

utenti della ricerca sono profondamente diverse in termini di prestazioni,

affidabilità e certezza dei tempi di calcolo.

Il numero degli utenti mobile

only, sempre più elevato, può in qualche modo rallentare la realizzazione

di infrastrutture di nuova generazione di rete fissa? Questo fatto potrebbe

condizionare anche l'evoluzione della rete GARR nei prossimi anni?

La fibra ottica è comunque imprescindibile anche con il prevalere dell’uso

del mobile. Quanti più utenti saranno connessi tanto più le antenne sono

destinate ad aumentare ed avranno necessità di interconnessioni in fibra.

Probabilmente, chi usa poco la rete tenderà ad abbandonare la connettività

fissa, mentre chi se ne serve costantemente avrà sempre più bisogno di alte

prestazioni. Nel mobile stiamo tornando a un modello con un accesso a volume,

cioè a consumo, perché la banda viene condivisa ed è piuttosto scarsa. Proprio

per questo saranno importanti nuove infrastrutture in fibra.

Per quanto riguarda la

rete GARR, per la tipologia e il volume di traffico dei nostri utenti non è

ipotizzabile che le tecnologie radio possano soppiantare le infrastrutture in

fibra. L’investimento fatto da GARR per avere fibra ottica di proprietà

garantisce la nostra comunità per i prossimi 15 anni. Sulla nostra

infrastruttura non vediamo limiti all’aumento della capacità nel futuro

prossimo. Già oggi la capacità massima è dell'ordine di 10 Tbps (per coppia di

fibre) e nei prossimi anni arriveremo a 100 Tbps, se non oltre.