L’analisi dei dati raccolti da un’innovativa indagine su 15 milioni di galassie ha portato un team di ricercatori a concludere che la materia oscura è più diluita nello spazio di quanto si pensasse finora. Lo studio, di prossima pubblicazione su MNRAS, contraddice dunque il modello di distribuzione di questa elusiva componente dell’Universo tracciato dalla missione Planck. Ma andiamo con ordine.

Secondo la ricetta dell’Universo svelata dalle osservazioni del satellite Planck, poco più di un quarto del contenuto dell’intero Universo è rappresentato dall’enigmatica materia oscura. Un ingrediente terribilmente importante, dunque. Lo scenario proposto dall’attuale modello cosmologico, infatti, prevede che l’attuale distribuzione delle galassie e degli ammassi in cui si aggregano siano la diretta conseguenza dell’azione della materia oscura che, a partire dalle minuscole disomogeneità iniziali, si è via via addensata in strutture sempre più grandi e massicce. La formazione di imponenti aggregati e strutture filamentose – un’autentica ragnatela cosmica – ha indotto anche la materia ordinaria (quella che compone i pianeti, le stelle e noi stessi) ad aggregarsi e originare galassie, ammassi e superammassi di galassie.

Le osservazioni di ammassi di galassie, come questa fantastica ripresa dell'ammasso Abell 2218 acquisita dal telescopio spaziale Hubble nel 2008, mostrano gli effetti della gravità sulla luce proveniente da sorgenti più distanti. Una distorsione prevista e descritta dalla Relatività Generale riconducibile alla materia (luminosa e oscura) che si trova lungo il cammino della luce emessa da sorgenti più distanti.

Studiare la distribuzione cosmica della materia oscura è un obiettivo incredibilmente complicato da raggiungere. Se, infatti, è possibile studiare gli effetti gravitazionali della materia oscura presente negli ammassi di galassie ricorrendo al fenomeno della lente gravitazionale, determinare la distribuzione della materia oscura al di fuori di queste aggregazioni è un’autentica sfida. Attualmente sono attivi tre progetti che si prefiggono questo obiettivo: due utilizzano telescopi posti sulle Ande cilene (KiDS al Cerro Paranal e DES a Cerro Tololo), mentre il terzo (HSC) sfrutta il Subaru Telescope alle Hawaii.

Proprio il progetto KiDS (Kilo-Degree Survey), condotto con il telescopio VST (VLT Survey Telescope) all’Osservatorio di Cerro Paranal in Cile, ha fornito a Hendrik Hildebrandt (Argelander Institut für Astronomie – Germania), Massimo Viola (Leiden Observatory – Paesi Bassi) e collaboratori i dati per studiare la distribuzione della materia oscura. Lo studio è stato diffuso online lo scorso novembre e verrà pubblicato a febbraio su MNRAS.

I dati di KiDS coprono un’area di cielo di circa 450 gradi quadrati – equivalenti a circa 2200 volte le dimensioni apparenti della Luna piena – e riguardano 15 milioni di galassie. A dispetto dei numeri, però, l’area scandagliata dal VST è solamente poco più dell’1% dell’intero cielo.

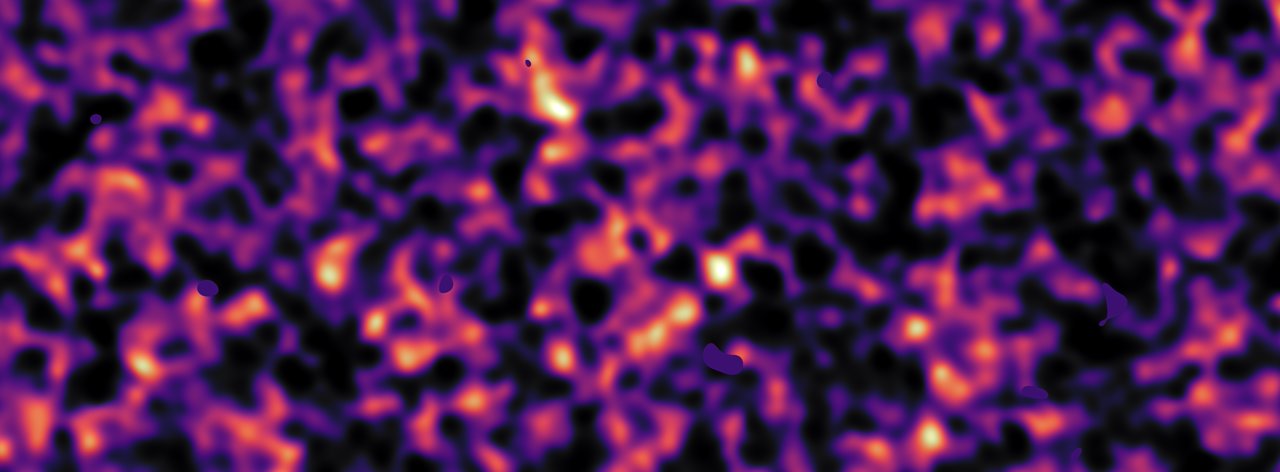

Molto meno evidente è l'effetto prodotto dalla materia (soprattutto quella oscura) che si manifesta nelle regioni dello spazio al di fuori degli ammassi di galassie. Nonostante sia estremamente debole, l'effetto può comunque essere rilevato e permettere di ricostruire la distribuzione della materia che può averlo generato. Questa è la ricostruzione della distribuzione della materia oscura - resa con una colorazione rosata - in una limitata regione di cielo ottenuta grazie ai dati della survey KiDS. La ricostruzione dell'immagine è stata fatta analizzando la luce proveniente da più di tre milioni di galassie poste a oltre 6 miliardi di anni luce e deformata dall'attrazione gravitazionale della materia oscura incontrata nel suo viaggio verso di noi.

L’eccezionale qualità delle immagini e la possibilità di effettuare misure accurate, unite all’impiego di un software innovativo, hanno permesso ai ricercatori di misurare l’effetto chiamato shear cosmico. Con questo termine si indica una variante del cosiddetto lensing gravitazionale debole, l’effetto in cui è la distribuzione stessa della materia nello spazio, poco importa se si tratta di materia oscura o materia ordinaria, che distorce la luce proveniente dagli oggetti più distanti. Lo shear cosmico è un effetto davvero sfuggente: la distorsione indotta sulle galassie di fondo è meno dell’1% di quella che si osserva nel lensing ordinario e il suo segnale può essere rilevato solamente grazie a survey molto ampie e profonde.

Lo studio di Hildebrandt e Viola ha messo in luce una distribuzione della materia oscura che sembra in contrasto con quanto si pensava finora. L’analisi dello shear cosmico, infatti, indicherebbe che la materia oscura ha una distribuzione più omogenea di quanto suggerito dagli attuali scenari dedotti dalla misurazione del fondo cosmico effettuata dal satellite Planck. In altre parole, la materia oscura non sarebbe esclusivamente concentrata negli ammassi di galassie e nelle strutture a grande scala, ma sarebbe distribuita in maniera più uniforme.

La discordanza con i risultati suggeriti da Planck comporta che la nostra comprensione del percorso evolutivo che ha condotto l’Universo a essere quello che oggi osserviamo non è poi così assodata come si pensava. La conferma di un simile disaccordo, insomma, comporterebbe inevitabilmente che i cosmologi debbano rivedere alcuni aspetti delle attuali descrizioni dello sviluppo dell’Universo.

Oppure – come ha sottolineato Koen Kuijken (Leiden Observatory), Principal Investigator del progetto KiDS – che si debbano rivedere le proprietà della materia oscura superando gli attuali modelli e, magari, prendendo persino in considerazione l’ipotesi che il comportamento della gravità possa essere differente su scale cosmologiche più grandi.

Probabilmente la risposta definitiva potrà essere data da survey più profonde ed estese a più ampie aree del cielo, in grado di esaminare le flebili deformazioni di miliardi di galassie. A tal proposito, per esempio, a partire dal 2020 dovrebbe essere operativo il satellite Euclid ed entrare in servizio il telescopio LSST (Large Synoptic Survey Telescope), attualmente in costruzione sulla sommità del Cerro Pachón, sulle Ande cilene.

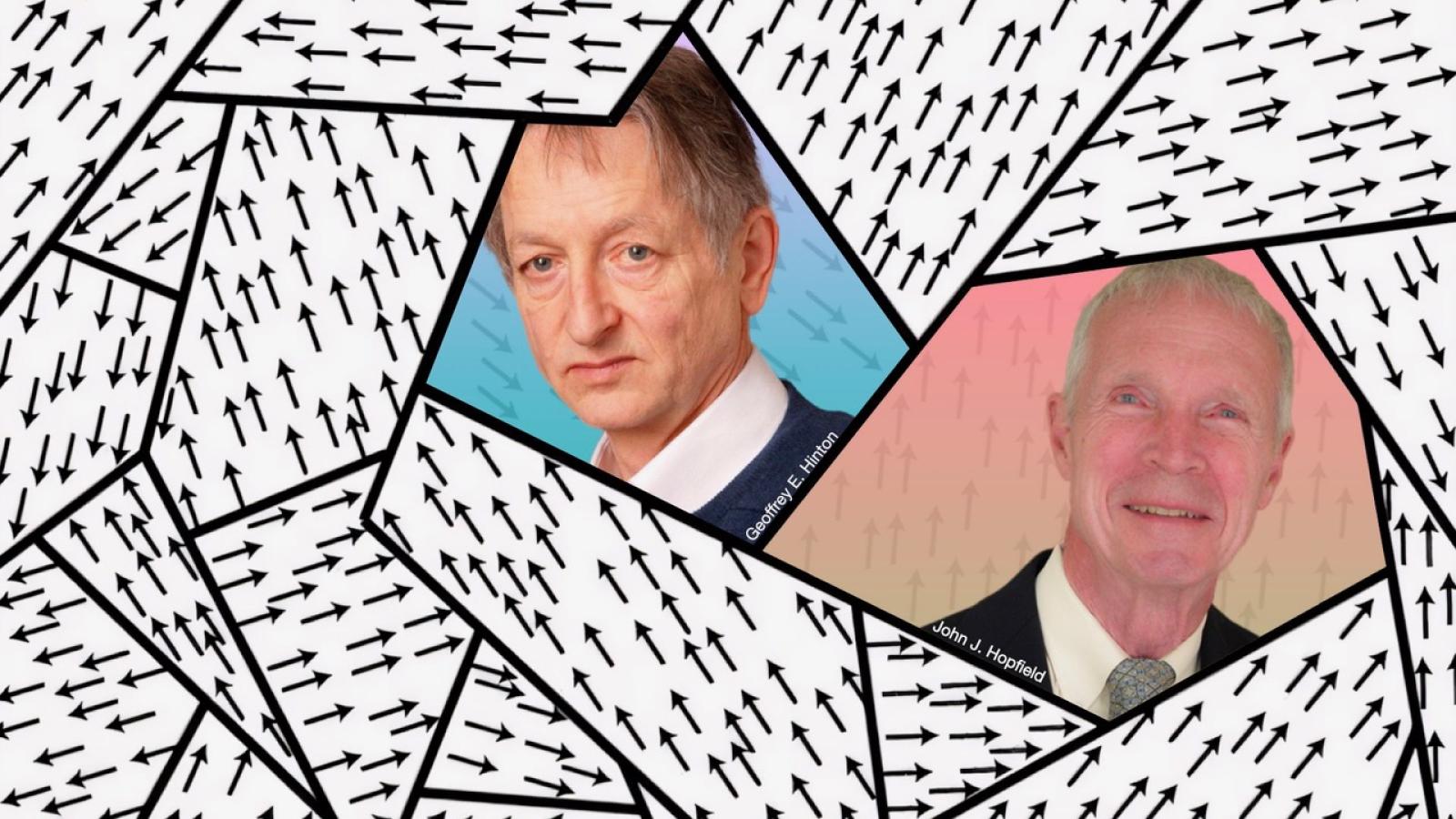

Massimo Viola: C'è qualcosa che non torna...

Per approfondire alcuni aspetti di questa scoperta e della innovativa tecnica che la supporta, abbiamo contattato Massimo Viola, coautore dello studio pubblicato su MNRAS e attualmente post-doctoral fellow al Leiden Observatory (Paesi Bassi).

Leggendo i commenti ai risultati pubblicati su MNRAS, emerge una duplice lettura. Da una parte si sottolinea l’importante traguardo di aver gettato un po’ di luce sulla distribuzione cosmica dell’enigmatica materia oscura, dall’altra si evidenzia il possibile contrasto con lo scenario derivato dai dati raccolti dalla missione Planck. Qual è il vostro punto di vista? Quale può essere la migliore chiave di lettura di questa scoperta?

Planck ha misurato con estrema precisione quanta materia ed energia oscura ci sono nell’Universo. Questi risultati sono basati sulle osservazioni delle fluttuazioni della radiazione cosmica di fondo che ci permettono di conoscere come era l’Universo 300.000 anni dopo il Big Bang. È possibile calcolare come tali fluttuazioni evolvono nel tempo fino ai giorni nostri, 13,4 miliardi di anni dopo il Big Bang. Le misure di KiDS sembrano essere in disaccordo con tali predizioni. L’Universo oggi appare più regolare di quello che i calcoli predicono (ad esempio ci sono meno ammassi di galassie massivi rispetto a quello che si può calcolare a partire dalle misure di Planck).

Ci sono diverse possibilità di lettura di queste misure: le proprietà della materia oscura e dell’energia oscura, di cui sappiamo molto poco, potrebbero essere più complicate di quanto i modelli più semplici assumono. Ad esempio, forme di energia oscura diverse dalla costante cosmologica di Einstein – che è attualmente la soluzione più semplice – possono spiegare le nostre misure. Un’altra eccitante possibilità è che le leggi di gravità su scale cosmiche potrebbero essere diverse da quello che predice la Relatività Generale di Einstein.

Quello che possiamo dire con certezza è che c’è qualcosa che non torna!

Qual è – ammesso che esista – il limite di affidabilità nei dati che sono alla base delle conclusioni pubblicate e che potrebbe affliggere e forse turbare le distribuzioni di materia oscura che è stata ricavata? Si tratta di un limite superabile con osservazioni future oppure è un problema insito nella stessa tipologia di osservazioni?

Gran parte del nostro lavoro pubblicato su MNRAS è volto alla verifica che le misure della distribuzione di materia oscura, ricavate utilizzando il fenomeno di lente gravitazionale debole, siano affidabili. Il “limite" delle nostre misure è la frazione di cielo osservato (circa l’1% del totale). KiDS osserverà nei prossimi anni un’area di cielo 3 volte più grande di quella utilizzata per le attuali misure e questo permetterà certamente di capire meglio l’origine del disaccordo con Planck. Risposte più certe arriveranno probabilmente nel prossimo decennio, quando la missione Euclid dell’Agenzia Spaziale Europea e il Large Synoptic Survey Telescope, in costruzione in Cile, osserveranno un’area di cielo 30 volte più grande e saranno in grado di misurare la distribuzione di materia oscura a epoche molto più remote di quanto siamo in grado di fare oggi.

Da alcuni cosmologi l’introduzione della materia oscura nella descrizione dell’Universo è vista come inutile e fuorviante e si suggeriscono modelli alternativi. Cosa ne pensate? È possibile giustificare il sottile effetto gravitazionale che è alla base di queste ricerche senza ricorrere alla distribuzione della materia oscura?

Se Einstein ha ragione e la sua teoria della Relatività Generale è valida anche su scale cosmologiche, l’unico modo di interpretare le osservazioni è quello di introdurre materia ed energia oscura. Alcuni cosmologici pensano che Einstein non abbia ragione e propongono teorie della gravitazione alternative. In tali modelli non è sempre necessario avere materia ed energia oscura. Come scienziato penso che ogni teoria debba confrontarsi con le osservazioni e come astronomo il mio compito è quello di produrre misure sempre più precise. Per ora il modello che meglio descrive il nostro Universo è quello basato sulla Relatività Generale. Rimane il mistero di cosa siano materia ed energia oscura…