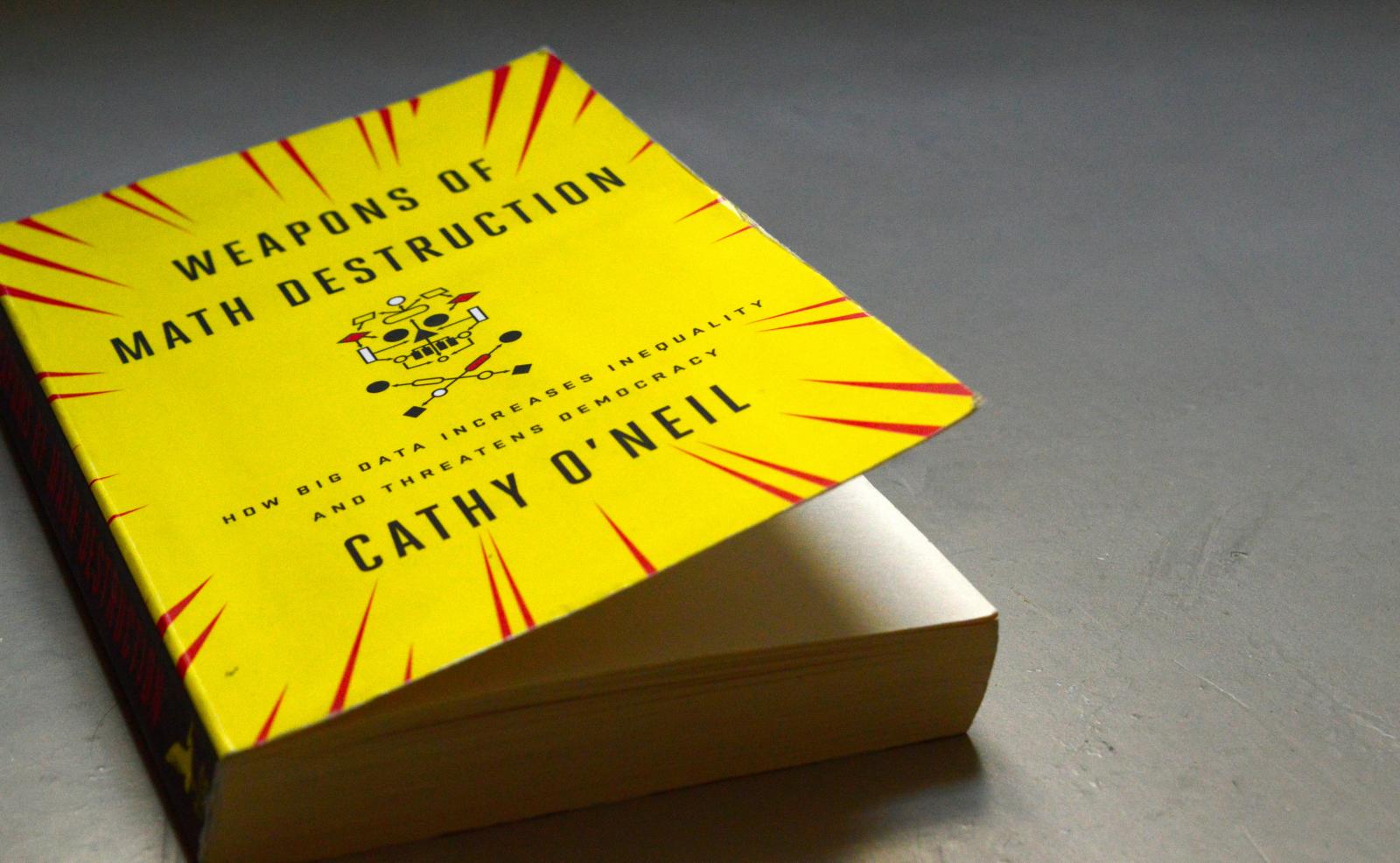

Pubblicità online, gestione del rischio finanziario, valutazione degli insegnanti delle scuole pubbliche, ranking delle università, sicurezza, giustizia, selezione del personale, organizzazione dei turni di lavoro, assicurazioni, campagna elettorale. Cos’hanno in comune queste attività? In ognuna di loro trova impiego uno tra i cosiddetti Weapons of math destruction, letteralmente “armi di distruzione matematica”, ma più propriamente “armi matematiche di distruzione di massa”, per rendere conto del riuscito gioco di parole che dà il titolo al secondo libro di Cathy O’Neil, pubblicato da Crown Publishing ad agosto del 2016, dal sottotitolo eloquente: "How big data increases inequality and threatens democracy".

O’Neil, che ha un dottorato in matematica a Harvard e un passato nel mondo della finanza quantitativa a Wall Street, oggi si occupa di equità degli algoritmi, il tema al centro del libro che è anche l’oggetto delle sue colonne settimanali su Bloomberg View. O’Neil ha poi fondato la società ORCAA (O’Neil Risk Consulting and Algorithmic Auditing) che si occupa di valutare l’equità e più in generale la qualità degli algoritmi.

Attraverso una serie di esempi, il libro ci mostra come gli algoritmi stiano diventando un pervasivo strumento di ausilio alla decisione per gli esseri umani. Uno strumento particolarmente insidioso dal punto di vista etico. Ammantati dell’aurea di oggettività che solo formule e numeri possono vantare, sembrano essere in grado di correggere la fallacia intrinseca nel ragionamento umano. Tuttavia gli algoritmi non sono che “opinioni tradotte in matematica” (letteralmente “opinions embedded in mathematics”) e incorporano due tipi di pregiudizi. In primo luogo quelli di coloro che sviluppano i modelli matematici e successivamente li traducono in codice. In secondo luogo reiterano le ingiustizie già in atto nella società. Come? Osservando i fenomeni sociali attraverso l’enorme mole di dati disponibile, i modelli matematici “apprendono” queste ingiustizie e le scolpiscono nella pietra digitale degli algoritmi. Il problema è che, al contrario delle persone, i weapons of math destruction (WMD) sono estremamente efficienti, in grado di esercitare instancabilmente questi pregiudizi.

Ma in che modo un algoritmo può diventare pericoloso? E per chi? La risposta è contenuta nell’introduzione e fa riferimento alle caratteristiche essenziali di un WMD: mancanza di trasparenza, capacità di agire su vasta scala generando un feedback negativo, tendenza a colpire i gruppi più deboli e favorire i più forti, incapacità di correggersi.

Il primo esempio di WMD rappresenta una sorta di paradigma. Alla fine del mese di maggio del 2011 Sarah Wysocki stava concludendo il secondo anno come insegnante in una scuola media di Washington D.C. . I suoi superiori, gli studenti e i loro genitori erano entusiasti del suo lavoro. Eppure, due mesi più tardi, Sarah viene licenziata. La decisione era stata presa in base ai risultati del programma di valutazione IMPACT, un sistema introdotto dal responsabile dell’istruzione della città nel tentativo di riformare il sistema scolastico su mandato del nuovo sindaco. IMPACT , tutt’oggi attivo, assegna a ciascun insegnante un punteggio. Coloro che si posizionano nel 2% più basso della classifica, vengono licenziati. Il punteggio è calcolato per metà in base all’osservazione di esperti durante le lezioni in classe e per l’altra metà dal risultato del Value Added Model messo a punto dalla società di consulenza Mathematica Policy Research.

Il Value Added Model ha l’obiettivo ambizioso di stabilire quanta parte del progresso scolastico annuale di ciascuno studente sia da attribuire all’insegnante. I progressi o i peggioramenti degli studenti sono il risultato di numerosi fattori: la condizione familiare, le possibilità economiche, la loro interazione con il resto della classe, il background culturale della famiglia. Per tenere conto di tutti questi elementi, il modello utilizza solo due informazioni: il diritto dello studente all’esenzione dal pagamento del pasto in mensa e le sue eventuali “learning disabilities” (quello che in Italia chiamiamo “bisogni educativi speciali”). Aggregando i dati relativi a tutte le classi che un insegnante ha avuto in un anno scolastico, il modello formula una previsione su qual è il progresso atteso per ogni singolo studente e lo confronta con quello effettivamente misurato nei test di fine anno.

Se un insegnante ha lavorato con una sola classe, il suo operato sarà valutato sulla base della performance di 15-20 studenti, un numero insufficiente ad ottenere risultati solidi dal punto di vista statistico. Anche ammesso di avere a disposizione un campione più numeroso, la procedura ha dei punti deboli. Per prima cosa il punteggio dipende molto dal voto ottenuto nei test di profitto dell’anno precedente: se i voti sono truccati, ad esempio, il punteggio ne risentirà. Il secondo limite, forse quello più grave, è l’estrema semplificazione con cui misura l’impatto delle vicende personali e familiari sull’andamento scolastico dei ragazzi.

Sarah Wysocki voleva sapere come era stato calcolato il suo punteggio e quello degli altri 200 insegnanti licenziati a Washington D.C. quell’anno. Molto presto scopre che è sostanzialmente impossibile capire il funzionamento dell’algoritmo: come utilizza i dati, come soppesa i diversi fattori. Tuttavia ha un sospetto. All’inizio dell’anno aveva notato che tutti gli studenti della sua classe avevano ottenuto voti sopra la media del distretto ai test dell’anno precedente, soprattutto nella lettura. Ma già durante i primi mesi Sarah si era resa conto che la loro abilità nella comprensione dei testi scritti era tutt’altro che eccellente. Un’inchiesta del giornale USA Today rivelò qualche mese più tardi, che almeno 70 scuole del distretto avevano truccato i test. Questo è il feedback negativo generato dall’algoritmo. Gli insegnanti modificano i loro comportamenti per conformarsi a ciò che questo premia. Purtroppo Wysocki non riuscì ad accumulare prove sufficienti per far riconsiderare il suo punteggio. E qui il paradosso: spesso agli esseri umani sono richieste prove molto più stringenti di quanto non si chieda a un algoritmo per provare la sua affidabilità.

Cathy O'Neil. Credit: Quartz/Johnny Simon.

Da qui parte il saggio che illustra come simili difetti siano presenti in numerosi altri campi. A rendere credibile e vivo, attraverso l’intero libro, il racconto di O’Neil è la sua storia personale, che lei stessa definisce un viaggio verso la disillusione. Dopo la laurea in matematica a Berkeley, il dottorato a Harvard e un post-doc a M.I.T., ottiene una cattedra al Barnard College della Columbia University. Pur amando la geometria algebrica, l’area della matematica in cui si è specializzata, trova insostenibile la lentezza con cui avanza la ricerca in quel campo. Decide quindi di utilizzare le sue capacità matematiche fuori dall’accademia. È il 2007 e la finanza si nutre sempre più di modelli matematici, così entra a far parte del team di analisti del fondo di investimento D.E. Shaw, proprio all’alba della crisi dei mutui sub-prime. È la prima tappa verso la disillusione. In questo periodo Cathy O’Neill si unisce al movimento Occupy Wall Street e comincia a scrivere di questi temi sul blog, ormai famoso, mathbabe.org. La seconda tappa verso il disincanto sarà Risk Metrics, la società di gestione del rischio finanziario che conobbe un enorme successo subito dopo la crisi del 2007-2008 grazie alla stretta normativa che ne seguì. O’Neil lascerà definitivamente Wall Street nel 2012, per diventare data scientist di Intent Media, una società di marketing on-line, e da lì maturerà la decisione di uscire definitivamente dal mondo della data economy per diventare algorithmic auditor, giornalista e attivista.

I sistemi di decisione automatizzata non si limitano certo al mondo dell’istruzione e Weapons of math destruction ci descrive, capitolo dopo capitolo, in quali ambiti si stanno diffondendo negli USA. Particolarmente rilevanti sono i software di polizia predittiva, che cominciano a essere sperimentati anche in Europa.

O’Neil racconta il caso della città di Reading in Pennsylvania, che nel 2011 conquistava un record poco invidiabile: il tasso di povertà pari al 41,3% era il più alto del Paese. L’ingresso nell’era post-industriale per una città dedita alla produzione di acciaio, carbone e tessili non era stato felice. Tra le varie misure per contenere la crisi, una aveva comportato il taglio di 45 unità del corpo di polizia. Per far fronte a una riduzione così sostanziale del personale, il capo della polizia decide nel 2013 di investire in un software di previsione del crimine sviluppato dalla start-up californiana PredPol. Un anno dopo annuncia di aver ridotto i furti del 23%. Un successo, apparentemente. Il software sviluppato da PredPol si concentra sulla geografia. Registra la posizione e il tipo di crimine commesso e prevede quali sono le zone dove è più probabile che si verifichi il prossimo. Non si concentra dunque sugli individui, ma nelle città statunitensi, dove spesso le fasce più deboli sono ghettizzate da quelle più forti, la geografia diventa un’ottima approssimazione per il gruppo etnico di appartenenza e il livello di reddito.

I poliziotti verranno dunque concentrati nelle aree a più alto rischio e pattugliando in quelle zone è probabile che intercettino piccoli crimini, come il vagabondaggio, o il consumo e spaccio di modeste quantità di droga. Arresteranno i sospettati e questo farà sì che l’algoritmo registri un successo e rinforzi la sua previsione, riempiendo però le carceri statunitensi di giovani afro-americani e ispanici colpevoli di reati minori.

Una volta giunto in carcere l’imputato dovrà affrontare un processo ed è molto probabile che si imbatterà in un altro WMD. Dal 1995 i detenuti in attesa di processo negli Stati Uniti compilano un questionario chiamato Level of Service - Revised. Rispondono a domande riguardanti condanne passate, dipendenza da droga e alcol, problemi con la giustizia, anche solo perquisizioni. Pur non riferendosi direttamente al gruppo etnico di appartenenza, al reddito o al livello di istruzione, il questionario in qualche modo ricostruisce queste informazioni. Basta immaginare un giovane cresciuto in un quartiere borghese: molto probabilmente non ha mai avuto rapporti con la giustizia prima. Un afro-americano, al contrario, sarà stato molto probabilmente sorpreso a fumare marijuana o a bere alcolici prima dell’età legale.

Sulla base dei dati raccolti dai questionari, è stato formulato il cosiddetto Risk Recidivism Model. Individuando quali informazioni sono maggiormente correlate con la ricaduta nel reato, il modello gli assegna un peso maggiore nel calcolare il risk recidivism score. Nel migliore dei casi, questo punteggio è utilizzato per inserire i condannati nei programmi di recupero attivi nelle prigioni, nel caso peggiore aiuta il giudice a stabilire la lunghezza della pena: più alto il punteggio, più tempo in galera. Il Risk Recidivism Model rischia così di diventare una profezia che si autoadempie. Scontando una pena più lunga la probabilità di trovare un lavoro, una volta liberi, è molto più bassa e di conseguenza aumenta la probabilità di commettere nuovamente un crimine. Una volta arrestato, in attesa di un nuovo processo, il detenuto avrà già una condanna alle spalle e il suo risk recidivism score schizzerà alle stelle.

Gli algoritmi sono basati su osservazioni statistiche di fenomeni sociali, ma le loro decisioni hanno conseguenze sui singoli. Ed è proprio sfruttando questa dialettica, tra le verità aggregate e quelle che riguardano ciascun individuo, che O’Neil costruisce la sua narrazione, riuscendo a chiarire il principio che dovrebbe guidarci quando utilizziamo strumenti automatici di assistenza alla decisione.