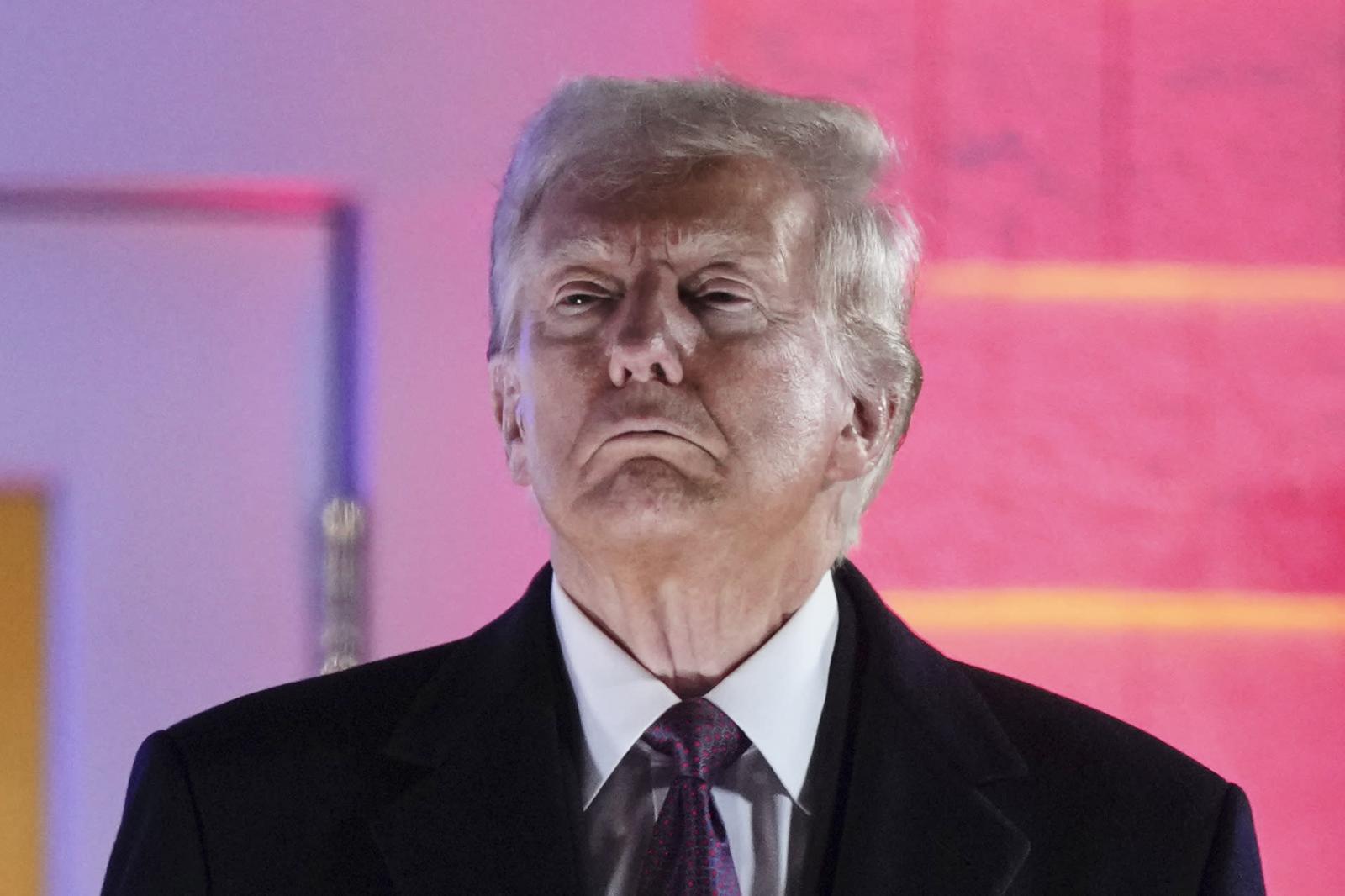

Un momento della concertazione cittadina avvenuta nell'ambito del dibattito "Éthique et numérique" a Montpellier il 14 ottobre 2017. Credit: CNIL.

Le rivelazioni di Chrstopher Wylie, data scientist canadese di 28 anni ex dipendente della società di consulenza Cambridge Analytica, confermano ancora una volta l’importanza degli algoritmi, in particolare quelli di machine learning (che basano cioè parte del loro funzionamento sui dati), nell’influenzare i processi sociali e, in ultima battuta, la vita dei singoli individui.

Quanto affermato da Wylie promette infatti di avere conseguenze su due diverse inchieste parlamentari: quella sulle interferenze russe nelle elezioni presidenziali americane del 2016 e quella riguardo il referendum britannico sull’uscita dall’Unione Europea. Wylie ha reso pubblici una serie di documenti che testimoniano come Cambridge Analytica sviluppò il suo algoritmo di microtargeting psicologico basandosi sui dati Facebook di decine di milioni di elettori americani, ottenuti illegalmente tramite la società Global Science Research, del ricercatore dell’Università di Cambridge Aleksandr Kogan. Kogan riuscì a raccogliere i dati dichiarando che sarebbero stati usati per scopi accademici, salvo poi venderli a Cambridge Analytica per un milione di dollari.

I rischi connessi all’utilizzo degli algoritmi come sistemi di assistenza alla decisione stanno emergendo in diversi ambiti: finanza, assicurazioni, accesso al credito, giustizia, sicurezza, gestione del personale e, appunto, informazione e propaganda politica. Li racconta bene Cathy O’Neil nel suo libro Weapons of math destruction (che abbiamo recensito qui), in cui si capisce chiaramente qual è il problema: gli algoritmi apprendono dai dati prodotti dai nostri comportamenti e in questi sono incorporati anche i nostri pregiudizi.

La République Numérique

Proprio gli algoritmi sono al centro del dibatitto pubblico francese "Éthique et numérique" (letteralmente "Etica e informatica"), che si è svolto nell'arco di 10 mesi, da gennaio a ottobre 2017, e che ha coinvolto professionisti di diversi settori e semplici cittadini. Il dibattito è stato coordinato dalla Commission nationale de l'informatique et des libertés (CNIL) su mandato di una legge promulgata a ottobre del 2016, la "Loi pour une Rèpublique Numérique", con l'obiettivo di guidare il processo di adattamento al nuovo Regolamento europeo sulla protezione dei dati personali, la cosiddetta "General Data Protection Regulation" (GDPR), che entrerà in vigore il 25 maggio prossimo. L'obiettivo dei legislatori è di mettere al centro di questo processo i diritti dei cittadini e dunque di rivolgersi prima di tutto a loro per conoscere opinioni e grado di consapevolezza su questi temi.

Il dibattito si è svolto attraverso 45 incontri animati da 60 partner sotto la guida della CNIL, cui hanno preso parte quasi 3000 professionisti del mondo dell'istruzione, della finanza, delle assicurazioni, della sanità della gestione del personale, e una concertazione cittadina, svoltasi a Montpellier il 14 ottobre 2017, a cui hanno preso parte circa 40 persone. Gli obiettivi del dibattito erano principalmente due: alimentare e informare il dibattito pubblico, formulare principi e raccomandazioni,

Quanto sanno i francesi degli algoritmi?

Il punto di partenza del processo partecipativo è stato un sondaggio condotto su un campione di 1000 cittadini francesi rappresentativo della popolazione. Dal sondaggio è emerso che l'83% degli intervistati ha già sentito parlare di algoritmi ma solo il 31% dichiara di avere un'idea precisa di cosa siano. Alla domanda "Secondo voi gli algoritmi sono presenti nella vita di tutti i giorni?", l'80% ha risposto affermativamente (molto presenti per il 37%, abbastanza presenti per il 43%), mentre quando interrogati sul futuro i rispondenti si sono divisi tra coloro che pensano che l'importanza degli algoritmi crescerà (65%), che rimarrà invariata (24%) e che diminuirà (11%). L'ultima parte del sondaggio si è concentrata sulla percezione dei cittadini francesi circa gli effetti degli algoritmi sulla società: rappresentano una minaccia o un'opportunità? Il risultato è leggermente sbilanciato in negativo, più persone hanno cioè risposto sì alle domande che delineavano le possibili conseguenze negative della diffusione degli algoritmi. Particolarmente interessante è la distribuzione per età: massimo scetticismo nella fascia fra 35 e 49 anni, massima fiducia nella fascia fra 18 e 24 anni.Il dibattito tra professionisti

I 60 partner che hanno animato il dibattito tra professionisti sono di diversa natura: organizzazioni del mondo dell'istruzione, associazioni di assicuratori, il Ministero della Cultura, associazioni dei gestori delle risorse umane, sindacati. Questi hanno organizzato 45 eventi in tutta la Francia, di cui 27 a Parigi e 14 in provincia (Caen, Lille, Bordeaux, Toulouse, Ax-Les-Termes, Marsiglia, Lione) e 4 negli Stati Uniti (in collaborazione con la "AI initiative'' promossa da The Future of Society alla Harvard Kennedy School). Il primo effetto di queste manifestazioni è stato di portare il tema all'attenzione pubblica, permettendogli così di uscire dai circoli di esperti e raggiungere i cittadini comuni.

Durante la prima parte dei dibattito sono state identificate sei questioni etiche riguardanti l'utilizzo degli algoritmi come strumenti di assistenza alla decisione:

- La fiducia verso la neutralità e oggettività degli algoritmi rischia di spingere gli esseri umani a scaricare su di essi la responsabilità delle scelte più delicate e controverse.

- Gli algoritmi rischiano di agire sulla base di pregiudizi, generare discriminazione ed esclusione sociale. Questo può avvenire per volontà di coloro che li programmano e mettono in opera, ma anche a loro insaputa.

- Le attività di profilazione volte a modellare le offerte commerciali rischiano di intaccare logiche collettive essenziali per la vita della nostra società (pluralismo democratico e culturale, distribuzione del rischio).

- Da una parte la raccolta e l'analisi di grandi quantità di dati provenienti da diverse fonti ha grandi potenzialità. Dall'altra la legge promuove una logica di minimizzazione. Le promesse dell'intelligenza artificiale giustificano una revisione della legge?

- È necessario promuovere un atteggiamento critico verso gli algoritmi e i sistemi automatizzati e autonomi in generale.

- Si può arrivare a parlare degli algoritmi come soggetti dotati di una propria etica?

Lealtà, vigilanza, riflessività

Nella seconda parte del dibattito sono stati formulati due principi che dovrebbero guidare lo sviluppo di un'intelligenza artificiale al servizio degil esseri umani. In primo luogo un principio di lealtà, non solo verso i singoli individui, ma verso la comunità. I danni che gli algoritmi possono causare sono spesso a carico dei gruppi sociali più vulnerabili e dunque è verso questi gruppi che bisogna avere un'attenzione particolare. In secondo luogo un principio di vigilanza e riflessività, allo scopo di contrastare l'inconoscibilità e l'opacità degli algoritmi, in particolare di quelli di machine learning, e arginare la diluizione delle responsabilità. Dal dibattito è emersa infatti la necessità di predisporre procedure di auditing periodiche da parte di tutti i soggetti coinvolti nelle attività degli algoritmi. Una strategia già presente nel documento pubblicato a maggio del 2016 dal Big Data Working Group istituito dall'allora Presidente Barack Obama all'interno del suo executive office.

Attenzione alle decisioni automatiche

La discussione ha inoltre analizzato come il Regolamento europeo di prossima attuazione affronta il problema degli algoritmi. La GDPR contiene infatti due articoli rilevanti per questa discussione. L'articolo 22 garantisce il diritto dei cittadini affinché nessuna decisione rilevante per la loro vita venga presa in maniera completamente automatica e che, nel caso in cui questo avvenisse, questi hanno diritto a una revisione della decisione e a conoscere il funzionamento dell'algoritmo che li ha giudicati. L'articolo 14 poi assicura il diritto del cittadino di conoscere la logica utilizzata dell'algoritmo che ha processato i suoi dati. Alcuni giuristi hanno messo in discussione l'applicabilità di questi articoli: come si stabilisce se una decisione è rilevante per la vita di un cittadino? È possibile richiedere l'intervento umano in un numero di situazioni che si preannuncia molto grande? E ancora: le aziende che utilizzano procedure automatizzate possiedono le competenze e le conoscenza necessarie e comunicare ai cittadini la logica di funzionamento degli algoritmi che usano (spesso acquistandoli da società specializzate)? I cittadini sono preparati? Il dibattito francese condivide nella sostanza questi dubbi e chiede di ripensare l'obbligo di intervento umano nelle decisioni e organizzare il processo di comprensione degli algoritmi e di identificazione delle responsabilità.

Queste riflessioni sono confluite nelle sei raccomandazioni finali rivolte tanto ai decisori politici quanto ai diversi membri della società civile:

- educare all'etica tutti gli anelli della catena algoritmica (sviluppatori, aziende, cittadini);

- rendere gli algoritmi comprensibili agli utenti e favorire una mediazione sul loro funzionamento;

- progettare gli algoritmi in modo che siano al servizio delle libertà fondamentali;

- costruire una piattaforma nazionale di auditing degli algoritmi;

- incoraggiare la ricerca su un'intelligenza artificiale etica, lanciando un progetto di interesse nazionale;

- rafforzare gli uffici che si occupano di etica nelle aziende.

La concertazione cittadina

L'evento conclusivo del dibattito è stato una concertazione cittadina svoltasi a Montpellier il 14 ottobre 2017, che ha coinvolto 37 partecipanti selezionati per autocandidatura in risposta all'appello degli organizzatori diffuso su diverse piattaforme (stampa, social media, consigli di quartiere, fiera delle associazioni di Montpellier). L'evento è stato organizzato e realizzato da cinque facilitatori professionisti dell'associazione Lisode, specializzata in processi partecipativi.La giornata si è svolta in quattro sessioni (1) e i risultati sono raccolti in dettaglio qui e possono essere riassunti nei seguenti punti:

- perdita di responsabilità e di competenza per impiegati e medici, che ricorreranno sempre più sistematicamente all'aiuto di un sistema automatizzato;

- gli algoritmi gestiscono l'incertezza e le eccezioni in modo peggiore rispetto alle persone, inoltre mancano di umanità (numerosi i riferimenti all'algoritmo che gestisce l'ammissione alle università francesi);

- mancanza di trasparenza;

- in relazione ai motori di ricerca e ai social media viene sottolineata una progressiva e pericolosa diluizione della responsabilità;

- il rischio di discriminazione e perpetuazione dei pregiudizi è percepito come particolarmente preoccupante nella gestione delle risorse umane, meno nelle attività di profilazione online.

La sfida di una IA sensibile ai diritti

Nelle prossime settimane verrà pubblicato il risultato dell'indagine sull'intelligenza artificiale condotta da Cédric Villani, matematico francese vincitore della prestigiosa medaglia Fields nel 2010 che si è unito al partito politico del Presidente Emmanuel Macron. Nel resoconto di medio periodo della missione, pubblicato a dicembre, vengono toccate in più punti le questioni relative agli aspetti etici dell'intelligenza artificiale (IA), in particolare in relazione all'utilizzo dei dati personali dei cittadini francesi. Il difficile compito di Villani è quello di suggerire una strategia che permetta di sfruttare le potenzialità dell'IA per la crescita economica proteggendo i diritti dei cittadini.

Note

Il dibattito conclusivo svoltosi a Montpellier il 14 ottobre 2017 si è articolato in 4 fasi:

-

Una sessione interattiva, con video, giochi e laboratori, in cui scoprire cosa sono gli algoritmi, in quali ambiti vengono usati e quali effetti potrebbero avere per la societ

-

Una sessione plenaria per: presentare più compiutamente la tematica oggetto di discussione e fornire alcuni elementi di base riguardanti le leggi e i regolamenti rilevanti; presentare quattro casi di studio; costituire quattro gruppi di lavoro.

-

Lavoro in sottogruppi, ciascuno su un caso di studio (salute, lavoro, motori di ricerca e profilazione, istruzione) per: identificare le opportunità offerte dall'utilizzo degli algoritmi in questo settore; identificare i rischi etici che l'utilizzo degli algoritmi in questo settore comporta; formulare raccomandazioni per uno sviluppo etico degli algoritmi in questo settore.

-

Riunione dei sottogruppi e discussione collettiva dei quattro lavori: prima con la tecnica di conversazione informale del world café; poi chiedendo di esprimere a ciascun partecipante un grado di consenso per ciascuna delle raccomandazioni formulate in precedenza per i quattro casi di studio.