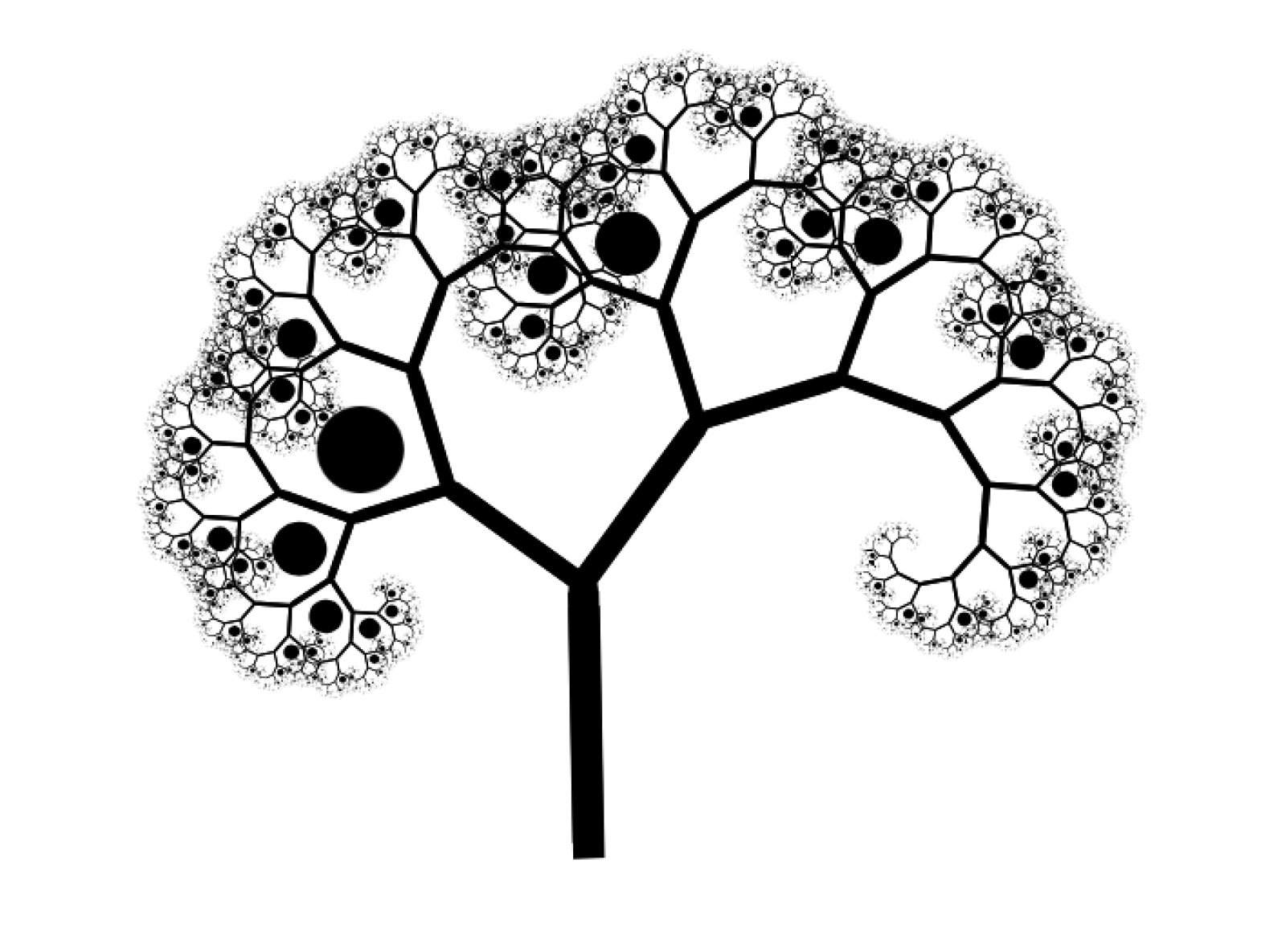

Un gruppo di oncologi, statistici, matematici e fisici dell'Istituto Tumori Giovanni Paolo II di Bari ha messo a punto un algoritmo per prevedere se una donna trattata per un tumore al seno andrà incontro a un nuovo episodio di malattia nei 5 e 10 anni successivi sulla base delle caratteristiche del tumore e delle terapie ricevute. Attualmente il modello di riferimento per scegliere il piano terapeutico da offrire a una donna con tumore al seno è quello delle breast unit gruppi multidisciplinari che esaminano collegialmente i casi anche facendo riferimento alle linee guida internazionali. Il lavoro di queste unità potrebbe beneficiare dell'aiuto di sistemi come questo, soprattutto se ben validati su una popolazione omogenea con quella del territorio di riferimento del centro clinico. Lo studio è stato pubblicato sulla rivista PLOS ONE. Immagine di Roo Reynolds (CC BY-NC 2.0).

Nel 2020 in Europa sono stati diagnosticati circa 355 500 nuovi casi di tumore al seno, corrispondenti al 30% delle diagnosi di nuovi tumori ricevute in totale dalle donne europee in quell’anno. Le morti associate sono state quasi 92 000 e rappresentano tra il 15% e il 20% del totale delle morti causate dal cancro tra le donne.

Considerando coloro che hanno ricevuto una diagnosi di tumore al seno tra il 2000 e il 2007, il tasso di sopravvivenza a cinque anni, cioè la percentuale di donne che sono ancora vive cinque anni dopo la diagnosi, è in media dell’82%, ma varia molto da paese a paese. In paesi come Italia, Francia, Germania è circa l’85%, mentre nei paesi dell’est scende al 74%.

I tumori al seno sono estremamente variegati dal punto di vista molecolare. Per esempio, negli anni Settanta del Novecento i ricercatori capirono che i tumori al seno che possiedono il recettore per l’ormone estrogeno, beneficiano dalla somministrazione del tamoxifene, un farmaco antagonista dell’estrogeno. Esistono altre caratteristiche che possono orientare in modo simile la scelta delle diverse terapie, che oggi comprendono oltre alla chirurgia, diversi protocolli di chemioterapia, ormonoterapia e radioterapia.

Tuttavia, ci sono ampi margini lasciati alla valutazione individuale degli oncologi.

Attualmente il modello di riferimento per la scelta delle terapie è quello di unità multidisciplinari dedicate, chiamate breast unit, in cui diversi specialisti si confrontano sui singoli casi e li discutono collegialmente anche alla luce delle linee guida internazionali.

Il lavoro delle breast unit potrebbe beneficiare dalle informazioni contenute nei dati che i centri clinici raccolgono sui loro pazienti. La sempre maggiore disponibilità di algoritmi di apprendimento automatico in grado di estrarre conoscenza da questi dati ha portato allo sviluppo di sistemi automatici di assistenza alla decisione che possano contribuire alla scelta delle terapie.

Secondo una rassegna pubblicata lo scorso anno sulla rivista PLOS ONE e che ha considerato una trentina di studi sul tema, la maggior parte di questi modelli sono stati sviluppati dopo il 2013 e si sono concentrati finora sulla previsione della sopravvivenza a cinque anni.

L’ampiezza dei campioni considerati, le performance di questi modelli e la possibilità di generalizzare i risultati su campioni diversi da quelli considerati negli studi sono molto eterogenee.

Tuttavia, la sopravvivenza non è l’unica misura significativa per valutare l’efficacia delle terapie. Esistono altri eventi che vale la pena considerare tra cui la ricomparsa dello stesso tumore o la comparsa di sue metastasi in altri organi, ma anche lo sviluppo di secondi tumori, diversi dal primo, oppure di tumori al seno inizialmente non interessato da malattia. È stato infatti osservato che la chemioterapia può aumentare il rischio di insorgenza di secondi tumori.

In un nuovo studio pubblicato a settembre sulla stessa rivista, un gruppo di oncologi, matematici e statistici coordinati dalla fisica medica Raffaella Massafra dell’Istituto Tumori Giovanni Paolo II di Bari ha sviluppato un algoritmo che prevede se la paziente a cinque o dieci anni dalla diagnosi andrà incontro non alla morte, ma a uno degli eventi elencati prima, quindi ricorrenze del tumore primario, metastasi, secondi tumori e tumori al seno opposto a quello della prima diagnosi.

Lo studio ha considerato un campione di 529 pazienti che si sono rivolte all’Istituto tra il 1995 e il 2019, ricevendo una diagnosi di tumore al seno.

Per ciascuna paziente sono state raccolte 28 variabili, tra cui la presenza dei recettori per estrogeno e altri ormoni, il diametro del tumore, la sua tipologia (duttale, lobulare o altro), il livello della proteina Ki67 che è correlata alla proliferazione del tumore, il grado di interessamento dei linfonodi. Sono state escluse le pazienti che hanno ricevuto chemioterapia o radioterapia prima di essere sottoposte a intervento chirurgico, così come quelle che presentavano metastasi in altri organi già al momento della prima diagnosi.

Tutte sono state trattate inizialmente con la chirurgia e successivamente sottoposte a diverse combinazioni di chemioterapia e ormonoterapia. Di queste 529 pazienti, 142 sono andate incontro a un nuovo episodio di malattia nei 5 anni successivi alla diagnosi e 111 nei 10 anni successivi.

L’approccio del gruppo di Bari è nuovo non solo per il tipo di esiti considerato, ma anche perché l’algoritmo è il risultato della combinazione di tre diversi algoritmi, ciascuno allenato a riprodurre al meglio gli esiti di tre diversi gruppi di pazienti.

«Ci siamo resi conto che nel campione c’erano pazienti con tumori molto simili tra loro e che avevano ricevuto terapie simili, ma che hanno avuto decorsi molto diversi», spiega Annarita Fanizzi, statistica e tra gli autori dello studio.

Per questo motivo, sfruttando quattro diversi tipi di algoritmi di classificazione, i ricercatori hanno individuato un gruppo di pazienti confondenti, su cui cioè le previsioni di tutti e quattro gli algoritmi fallivano nel prevedere se si fosse o meno verificato uno degli episodi tra ricorrenza, metastasi e tumori secondari. Sono stati quindi creati altri due campioni di dati a partire da quello iniziale, uno con soli pazienti non confondenti e l’altro con soli pazienti confondenti.

Sono stati così ottenuti tre modelli, il primo allenato su un database misto, contenente sia pazienti confondenti che non confondenti, il secondo su quello con soli pazienti non confondenti e il terzo con soli pazienti confondenti. L’allenamento dei modelli è stato effettuato tramite una procedura ripetuta, spezzettando il campione di allenamento in cinque sottocampioni. Al primo passo il modello è stato allenato su quattro sottocampioni e testato sul quinto, al secondo è stato scelto un altro sottocampione per il test e i restanti quattro sono stati usati per l’allenamento. Questa procedura è stata ripetuta più volte, per vedere se il modello era stabile.

«I tre modelli sono poi stati poi testati su dieci campioni di dati indipendenti, selezionati all’inizio e non utilizzati nelle procedure di allenamento», spiega Samantha Bove, matematica e tra gli autori dello studio. «Questi campioni contenevano sia pazienti confondenti che pazienti non confondenti», precisa. Come era atteso, la performance dei tre modelli si è degradata, in particolare per il terzo modello.

I ricercatori hanno dunque pensato di formulare un sistema di regole per combinare le risposte dei tre modelli, ammettendo anche dei casi in cui la risposta finale fosse “non so”. Questa risposta emerge quando i risultati dei tre modelli su una singola paziente sono difficili da conciliare tra loro.

L’algoritmo risultante, che in gergo viene chiamato di ensemble perché è in sostanza un insieme di algoritmi, ha raggiunto, per l’orizzonte dei 5 anni, accuratezza del 76%, sensibilità del 64% e specificità del 76%, e per l’orizzonte dei 10 anni, accuratezza del 71%, sensibilità del 66% e specificità dell’82%.

«Il risultato è soddisfacente ma non è ancora sufficiente per introdurre questo strumento nella pratica clinica», commenta Fanizzi e aggiunge «stiamo già lavorando a un nuovo modello che consideri altre caratteristiche del tumore, per esempio le immagini digitalizzate delle analisi istopatologiche raccolte al microscopio, oppure dati di natura genetica».

Queste informazioni potrebbero aiutare a discriminare tra loro le pazienti confondenti. Persone che ora appaiono simili stando alle variabili raccolte nel database potrebbe essere distinte guardando a qualche caratteristica genetica o istopatologica dei loro tumori.

Il maggiore ostacolo all’arricchimento dei dati deriva dalla necessità di avere un numero sufficiente di pazienti. Le immagini di patologia digitale sono disponibili solo per le pazienti che si sono rivolte al centro negli ultimi anni e possono essere di difficile reperimento per coloro che non hanno effettuato il follow-up presso lo stesso istituto.

«Per questo puntiamo a realizzare uno studio multicentrico che coinvolga altri istituti sul territorio almeno regionale», commenta la matematica Maria Colomba Comes, seconda autrice dello studio. Tuttavia, questo tipo di studi richiedono accordi di tipo legale ed etico che permettano di condividere i dati, e questi accordi richiedono tempo.

«Il valore aggiunto del modello che abbiamo sviluppato, è che si concentra sulla popolazione di pazienti che vive sul nostro territorio di riferimento», aggiunge Fanizzi e conclude «esistono algoritmi proprietari o open source che offrono previsioni simili, ma spesso sono stati validati su popolazioni molto diverse dalla nostra per origine geografica ed è noto come questo influenzi l’efficacia delle terapie e il decorso della malattia».