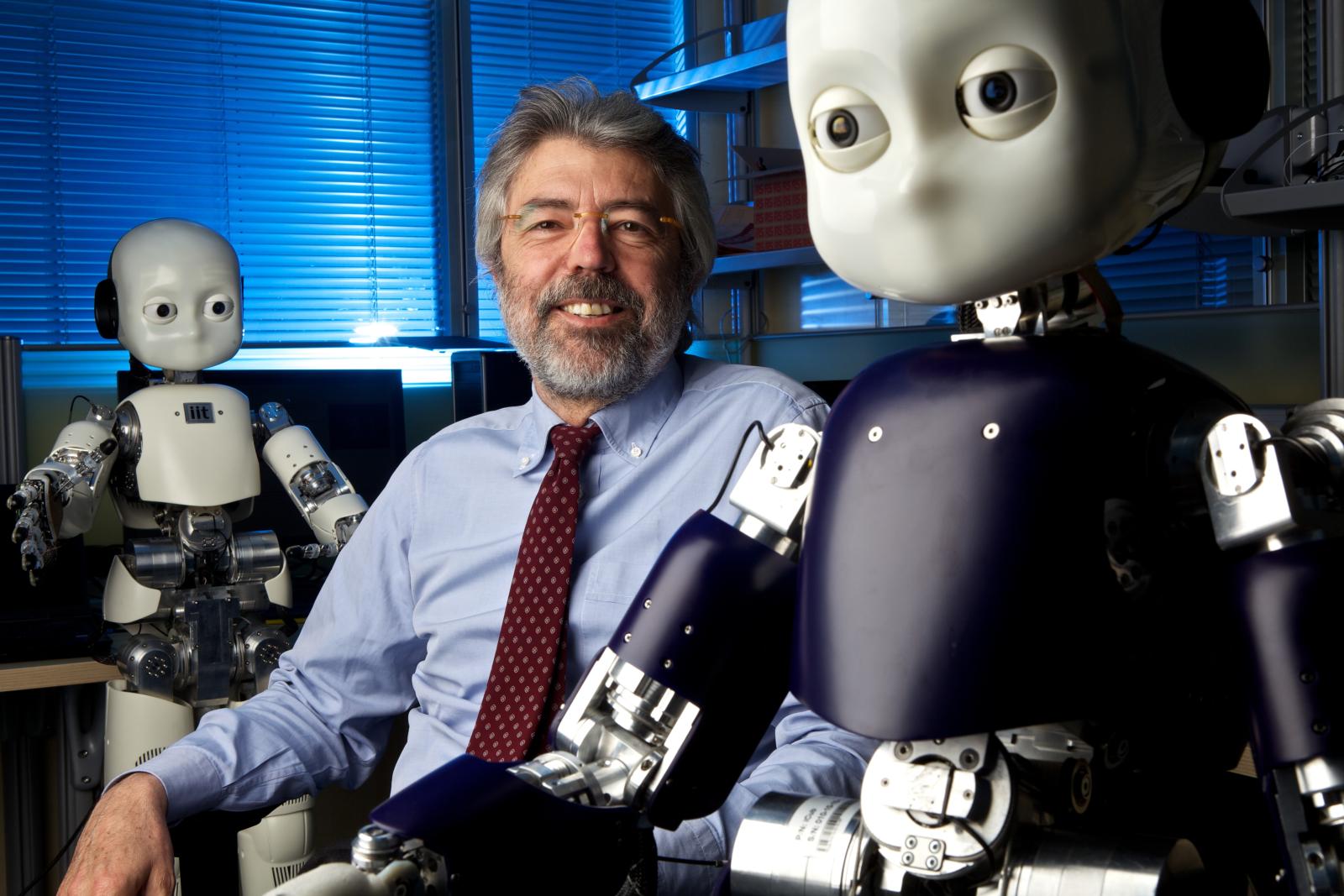

Giulio Sandini, direttore del dipartimento di Robotica, Scienze Cognitive e del Cervello dell’Istituto Italiano di Tecnologia, tra i relatori al convegno sull’Intelligenza Artificiale al Museo Scienza e Tecnologia di Milano di martedì 27 febbraio, ci spiega sfide, promesse e limiti della tecnologia robotica, aiutandoci a comprendere le profonde differenze tra l’intelligenza di un robot e l’intelligenza umana. Nella foto, Giulio Sandini accanto al celebre robot antropomorfo iCub.

Quando si pensa ai robot, spesso nell’immaginario collettivo li si dipinge come umanoidi, dotati di un notevole grado di autonomia, pronti a mettersi al servizio dell’essere umano, quando non a prenderne il posto o addirittura, se la fantasia prende un segno negativo, a ribellarsi e spodestarlo.

Siamo piuttosto lontani dalla realtà.

Come spiega Giulio Sandini, che dirige il dipartimento di Robotica, Scienze Cognitive e del Cervello dell’Istituto Italiano di Tecnologia (IIT) ed è stato professore ordinario di Bioingegneria presso l’Università degli Studi di Genova, i robot ad oggi sono lontanissimi dall’avere autonomia e capacità di interazione con l’ambiente comparabili a quelle umane. Anche di questo Sandini parlerà al convegno Dall’Intelligenza Artificiale agli impianti nel cervello: l’essere umano non sarà più solo biologico?, che si tiene il 27 febbraio al Museo della scienza e della tecnologia Leonardo Da Vinci di Milano (qui il programma).

iCub: nato per studiare lo sviluppo della capacità cognitive

Lo scopo per cui è stato progettato iCub, il primo e più iconico robot tra i diversi realizzati all’IIT, è quello di utilizzarlo come modello “fisico” per studiare lo sviluppo delle capacità sensoriali, motorie e cognitive umane (la parola cub è il termine inglese per “cucciolo”).

Attraverso il robot umanoide iCub più che studiare le applicazioni dell’intelligenza artificiale, si cerca di capirne le differenze rispetto all’intelligenza umana.

Il robot iCub è stato creato per questo, spiega Sandini: «Seguendo quello che sappiamo dello sviluppo delle capacità cognitive nell’umano, ci siamo dati come obiettivo scientifico quello di sviluppare un sistema che non sia necessariamente intelligente all’origine, ma che sia in grado di svilupparsi e diventarlo, in maniera incrementale, un po’ come facciamo noi umani: imparando attraverso l’interazione con l’ambiente e con l’essere umano e/o con altri agenti artificiali».

La strada, sottolinea Sandini, è però ancora lunga.

«Bisogna essere realisti su quello che i robot sono in grado di fare adesso e sulle difficoltà che ancora ci sono da superare per arrivare a realizzare sistemi come quelli che popolano i film di fantascienza. Dobbiamo tener conto che c’è una certa ambiguità tra quello che si vede al cinema e i filmati simili, che riprendono i robot sviluppati nei laboratori scientifici; questa ambiguità deriva dal fatto che quando vediamo una forma antropomorfa che si muove le attribuiamo implicitamente capacità umane (“la nostra immaginazione non può essere che antropomorfa” diceva Calvino nelle sue Lezioni americane) e quindi pensiamo che le azioni del robot siano guidate da meccanismi simili a quelli umani e quindi da un processo “intelligente”».

Il robot in fondo non è diverso da una marionetta

L’attribuire intelligenza quando si osserva il movimento di una struttura articolata, un fenomeno evidente anche quando guardiamo cartoni animati, si verifica a maggior ragione nel caso dei robot umanoidi, progettati per avere una struttura simile alla nostra. Quando si vede un robot che ha una forma umana ci si aspetta che sia in grado di comportarsi come un umano: è una reazione naturale, il nostro cervello interpreta in senso antropomorfo il movimento di altri esseri. Questo meccanismo è alla base della nostra capacità di immedesimarci negli altri e, in qualche misura, di essere in grado di capirne le intenzioni. Per questo motivo, quando osserviamo un robot che si muove o un pupazzo animato, dobbiamo sforzarci di capire “che cosa c’è dietro”, quali processi stanno dietro a quei movimenti apparentemente intelligenti.

Spiega infatti Sandini: «Nel caso di un burattino sappiamo che l’intelligenza è certamente nel burattinaio, ma anche nello spettatore che si immedesima nel burattino e si lascia commuovere dai suoi movimenti. Nel caso di un robot, che esegue lo stesso movimento e stimola le stesse emozioni, sappiamo per certo solo che l’intelligenza è nell’osservatore: se si osserva un robot che afferra un bicchiere e compie il gesto di bere, una valutazione superficiale ci porta a concludere che sia un robot talmente intelligente da essere in grado di svolgere non solo una serie di processi motori e percettivi, relativamente complicata, in maniera autonoma, ma anche che il robot abbia l’intenzione di afferrare il bicchiere. Mentre in realtà sta semplicemente eseguendo un programma informatico, che ogni volta che riconosce un bicchiere cerca di afferrarlo. In questo caso il robot non è diverso da una marionetta, che al posto dei fili ha delle righe di codice e ripete sempre la stessa azione. Un comportamento certamente non intelligente. Quello che manca al robot è l’intenzione, la capacità di decidere che azione eseguire per raggiungere un obiettivo (bere dell’acqua) sulla base dell’esperienza passata e della situazione contingente e, soprattutto, la capacità di sviluppare e accumulare nuova conoscenza in conseguenza dell’azione. La difficoltà non è tanto nell’eseguire una azione e neppure imparare a eseguirla sempre meglio, ma nella capacità che noi abbiamo di trovare modi nuovi per eseguirla senza che nessuno ce l’abbia insegnata (riuscireste a bere da un bicchiere con le mani legate dietro alla schiena?)».

Bisogna insomma chiedersi se il sistema è in grado di generalizzare, di trasferire le capacità acquisite ad altri contesti. Il consiglio è quindi di non fermarsi all’osservazione del comportamento, ma cercare di capire che cosa c’è dietro, quali sono i processi (i programmi) che realizzano il comportamento.

Come sottolinea Sandini: «Benché dotati di tecnologie complesse e molto interessanti, come sensori sempre più sofisticati per percepire l’ambiente esterno e attuatori sempre più veloci e precisi per muoversi, i robot che sembrano intelligenti potrebbero invece essere “semplici” sistemi reattivi, che eseguono misure sensoriali (“cerca un bicchiere”) che hanno una conseguenza motoria (“afferra il bicchiere”): vedo un oggetto rosso e rotondo e lo afferro, altrimenti non faccio nulla. Anche se sono la componente di base di un sistema intelligente, e certamente non semplici da realizzare in un sistema artificiale, si possono paragonare a comportamenti riflessi. Manca l’intenzione, la capacità di prendere decisioni e questo fa capire quanto siano infondate le idee di robot che prendano il sopravvento sull’umano, che presuppone esattamente l’opposto: la capacità di prendere decisioni sulla base di un’esperienza acquisita e di eseguire un’azione per raggiungere l’obiettivo previsto (immaginato). È proprio quello che manca ai robot».

La robotica e l’intelligenza artificiale

Ma quali sono le relazioni tra robotica e intelligenza artificiale?

«Qui c’è un’ambiguità – chiarisce Sandini – . Un conto è parlare di un’intelligenza artificiale tipo Chat GPT che si basa esclusivamente sulla ricerca di una correlazione fra dati acquisiti, diverso è parlare dell’intelligenza di un sistema dotato di un corpo, un sistema incarnato o “embodied” come si dice in inglese. Chat GPT si basa su dati, acquisiti attraverso i sistemi più disparati e sintetizzati. Nel caso di robot il risultato di quella che potrebbe essere chiamata intelligenza è invece un comportamento: il robot si deve in qualche maniera muovere, compito diverso, perché non è più sufficiente utilizzare dati acquisiti, ma è necessario generare nuovi dati, utilizzando un modello del corpo del robot, una sua rappresentazione interna, e l’esperienza acquisita mediante quel corpo. Se vogliamo far diventare intelligente un robot dobbiamo trovare soluzioni e tecnologie che al momento non ci sono e, se siamo interessati ad un’intelligenza “umana” (ma ne esistono altre?), la ricerca di soluzioni può consentire di capire meglio noi stessi. In questo caso si fa riferimento alle scienze cognitive e alla robotica cognitiva come modelli di sistemi “embodied” in grado di acquisire e utilizzare conoscenza acquisita anche in modo autonomo».

Oltre alle capacità percettive e motorie, il robot deve insomma sviluppare le capacità cognitive che consentono agli esseri umani e ad altri esseri viventi di essere in grado anticipare l’effetto delle azioni che stanno eseguendo. Per farlo, si parte dalle esperienze acquisite in passato.

Sandini propone un esempio apparentemente banale: scegliere di aprire una maniglia con il gomito perché abbiamo le mani occupate: «Nessuno ce l’ha insegnato, ma lo facciamo perché abbiamo acquisito conoscenza sugli obiettivi da raggiungere e sui vincoli imposti dall’ambiente e siamo in grado, letteralmente, di immaginare le azioni prima di eseguirle in modo da trovare, fra le soluzioni possibili, quella che meglio si adatta alla situazione contingente. Non si tratta tanto della capacità di memorizzare, di immagazzinare informazioni, quanto di andare a ripescarle nel modo e nel momento giusto nella memoria, un’operazione molto più complicata».

E questo, ad oggi, ai robot manca. Si tratta di una capacità di cui sono privi.

Come spiega ancora Sandini: «Mentre Chat GPT acquisisce conoscenze già esistenti, per esempio dalla rete, un sistema robotico con queste capacità cognitive sarebbe in grado produrre conoscenza “personalizzata”, sulla base di precedenti nozioni che ha già acquisito. Un sistema artificiale ad oggi riparte sempre da zero, nell’ambito della robotica: la conoscenza degli aspetti cognitivi è molto meno sviluppata della capacità di sincronizzare le percezioni con i movimenti (la cosidetta coordinazione sensomotoria). Un robot è in grado di imparare ad afferrare un bicchiere, se correttamente programmato: attraverso una serie di telecamere e sensori, il robot può infatti effettuare una serie di misure e su questa base eseguire un’azione. Ma non riuscirà autonomamente a modulare l’azione a seconda dell’obiettivo: per esempio a prendere una tazza per il manico se è per bere o per il corpo se è per passarla a un altro. Anche su questo il robot dovrà essere istruito con un programma specifico, non possiede le funzioni cognitive necessarie a capirlo».

Le applicazioni dei robot nella cura e le sfide per il futuro

Questo non significa, ovviamente, che i robot sviluppati fino ad oggi non possano essere già utili, anche in ambito clinico.

Racconta Sandini: «Nell’ambito della robotica chirurgica e per la realizzazione di dispositivi di riabilitazione ci sono strumenti già utilizzati in ambito clinico, anche in IIT sono stati sviluppati sistemi che consentano di aiutare il fisioterapista sia a eseguire movimenti esercitando una forza molto controllata e personalizzata sia per misurare in maniera quantitativa l’effetto dell’intervento fisioterapico. Per realizzare i primi prototipi di questi dispositivi si utilizzano gli stessi motori e la stessa elettronica sperimentati nel nostro robottino umanoide. A livello sperimentale è stata applicata la possibilità di far eseguire movimenti particolari a un robot umanoide, che possa permettere di interagire con più facilità con una persona con sindrome dello spettro autistico: anche se questo rimane un ambito di frontiera, ci vuole molta cautela prima di parlare di reali vantaggi».

In conclusione, qual è il campo più importante della ricerca sui robot oggi?

Per Sandini, la progettazione dell’architettura cognitiva del sistema: «Per quello che mi riguarda, dopo aver realizzato robot con capacità sensorimotorie di base e sperimentato l’apprendimento di semplici compiti motori, la sfida è quella di iniziare a pensare a come progettare la struttura della mente del sistema artificiale nel suo insieme: l’architettura cognitiva del sistema. La struttura funzionale di un sistema, cioè, in grado di costruire esperienza di quello che è successo nel passato e di ripescare dalla memoria i ricordi necessari a simulare mentalmente diverse soluzioni prima di scegliere quella che meglio si adatta alla situazione contingente, ovvero che consente di raggiungere l’obiettivo rispettando i vincoli contingenti. Oggi siamo molto bravi a insegnare tante cose ai robot una alla volta, ma senza che ci sia una sistema-mente che le mette insieme. Un sistema in grado, come si dice, di generalizzare e di trasferire quello che ha imparato facendo una cosa per impararne un’altra: cioè che se imparo a giocare a tennis mi aiuta a imparare a giocare a ping pong o a paddle, un sistema che viva nel mondo. In sintesi: il progetto della struttura di un sistema in grado di ricordare quello che ha fatto, di associare i ricordi e di immaginare il futuro. Un’architettura certamente molto complessa, e per realizzarla dovremo allearci con neuroscienziati, filosofi, sociologi, umanisti, artisti, perché l’obiettivo richiede di capire il funzionamento del nostro cervello e le basi della nostra umanità, ma, anche se ci vorranno molte decine, forse centinaia di anni, lungo la strada avremo imparato molto di noi umani e sviluppato tecnologie che oggi ancora non ci sono. E i robot non ci faranno più paura».